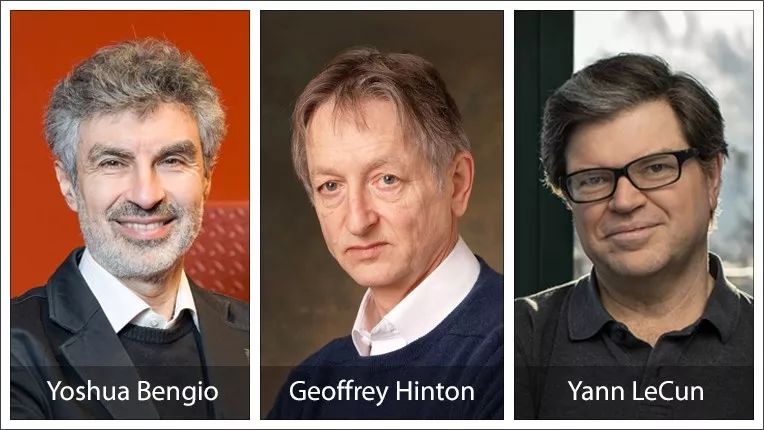

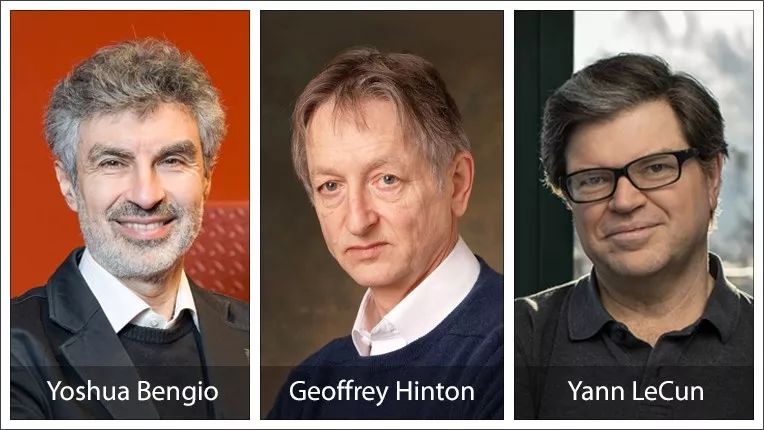

2019年3月27日,计算机领域最高奖项“图灵奖”颁给了深度学习领域的三大巨头——加拿大蒙特利尔大学教授约书亚·本吉奥(Yoshua Bengio)、谷歌副总裁兼多伦多大学名誉教授杰弗里·辛顿(Geoffrey Hinton)以及纽约大学教授兼 Facebook首席AI科学家杨立昆(Yann LeCun)。

图灵奖,通常被称为“计算机界的诺贝尔奖”,由Google提供资金支持,奖金为100万美元。它以英国数学家Alan M. Turing的名字命名,图灵发现了计算机的数学基础和及其运行限制。

如今深度学习技术在很多领域都有着深入的应用。比如近几年发生的AlphaGO大胜围棋冠军柯洁,AlphaStar在《星际争霸2》游戏中击败3位职业选手。另外,在我们的生活中,图像识别、语言翻译、社交机器人、AI医疗,甚至手机的美颜相机,背后都有深度学习的影子。

然而三十多年前,深度学习的研究者却被其他人称为“异类”。就是这一小撮人坚持这个研究方向,坚信模拟神经网络的学习算法可以改变世界,并改变整个人类的命运。杰弗里·辛顿的至交好友、全球十大AI科学家之一的特伦斯·谢诺夫斯基在新书《深度学习:智能时代的核心驱动力量》中,详细回顾了深度学习技术的发展历程,也讲述了三位图灵奖得主在深度学习研究过程中的贡献。

什么是深度学习?

深度学习指的是用计算机模拟神经元网络,以此逐渐“学会”各种任务的过程,比如识别图像、理解语音甚或是自己做决策。这项技术的基础是所谓的“人工神经网络”,它是现代人工智能的核心元素。人工神经网络和真实的大脑神经元工作方式并不完全一致,事实上它的理论基础只是普通的数学原理。但是经过训练后的人工神经网络却可以完成很多任务,比如识别照片中的人物和物体,或是在几种主要语言之间互相翻译等等。

深度学习的起点

20世纪50年代,尽管人们对大脑功能缺乏足够的了解,但神经网络的 AI 先驱们依然依靠着神经元的绘图以及它们相互连接的方式,进行着艰难的摸索。康奈尔大学的弗兰克·罗森布拉特是最早模仿人体自动图案识别视觉系统架构的人之一。他发明了一种看似简单的网络感知器(perceptron),这种学习算法可以学习如何将图案进行分类,例如识别字母表中的不同字母。

图1 单层感知器

感知器是具有单一人造神经元的神经网络,它有一个输入层,和将输入单元和输出单元相连的一组连接。感知器的目标是对提供给输入单元的图案进行分类。在人工神经网络领域中,感知器也被指为单层的人工神经网络,以区别于较复杂的多层感知器(Multilayer Perceptron)。 作为一种线性分类器,(单层)感知器可说是最简单的前向人工神经网络形式。尽管结构简单,感知器能够学习并解决相当复杂的问题。

神经网络的寒冬

神经网络的早期历史,其实就是一个不大但颇具影响力的团队,如何能够将研究方向带离正轨的案例。在1969 年发表的数学专著《感知器》(Perceptrons)。他们明确的几何分析表明,感知器的能力是有限的:它们只能区分线性可分的类别。

这本书的封面展示了明斯基和帕普特证明的感知器无法解决的几何问题。尽管在书的末尾,明斯基和帕普特考虑了将单层感知器进行泛化成为多层感知器的前景,但他们怀疑可能没有办法训练这些更强大的感知器。不幸的是,许多人对他们的论断坚信不疑,于是神经网络这个研究领域渐渐被人们遗忘,直到20 世纪 80 年代,新一代神经网络研究人员开始重新审视这个问题。

图2 马文·明斯基和西摩尔·帕普特,照片拍摄于1971 年

毫无疑问,其结果导致了网络学习领域的寸草不生。在明斯基和帕普特的书中,这种毫无根据的“直觉”对神经网络学习的发展产生了令人不寒而栗的影响,让一代人的研究就此停滞不前。

一小撮研究者的坚守

1973年,杰弗里·辛顿进入爱丁堡大学研究生院。他的论文导师是克里斯托弗·朗古特–希金斯(Christopher Longuet-Higgins)。希金斯是一位杰出的化学家,他发明了一种早期的联想记忆网络模型。那时,实现人工智能的主流方式是基于使用符号、逻辑和规则来编写智能行为的程序;认知心理学家已经采用这种方法来理解人类的认知能力,尤其是语言。而那时的杰弗里却在逆流而行。没有人能预见到他有朝一日会搞清楚大脑——或者至少类似大脑的某种东西——的工作原理。

特伦斯·谢诺夫斯基和杰弗里·辛顿在1979 年他组织的一次研讨会上相识。因为对神经网络模型的未来抱有相似的信念,我们很快就成了朋友。后来我们合作研究出了一种新型神经网络模型,叫作“玻尔兹曼机”(Boltzmann machine),并就此打破了阻碍一代人研究多层网络模型的僵局。

图3 特伦斯·谢诺夫斯基(左)和杰弗里·辛顿(右)在波士顿讨论视觉网络模型,照片拍摄于 1980 年

1985年杰弗里·辛顿和特伦斯·谢诺夫斯基发表了文章《玻尔兹曼机的一种学习算法》(A Learning Algorithm for Boltzmann Machines),这是马文·明斯基和西摩尔·帕普特被广泛接受的观点的反例,后者认为为多层网络开发学习算法是不可能的。

20 世纪 80年代,杰弗里·辛顿和特伦斯第一次见到法国学生杨立昆。杨立昆在9岁时,就深受1968年史诗级的科幻电影《2001 太空漫游》中的任务计算机 HAL 9000的启发,想要开发人工智能。他曾独立发明了反向传播误差算法的一种版本,并记录在他 1987 年的博士论文中,10 之后他就搬到多伦多,加入了杰弗里的团队。

后来,他转去了美国电话电报公司(AT&T)在新泽西州霍姆德尔(Holmdel)的贝尔实验室,在那里他创造了一个可以读取信件上的手写邮政编码的网络,采用修订的美国国家标准与技术研究院(Modified National Institute of Standards and Technology,简称MNIST)数据库作为一种标记数据基准。每天有数百万封信件需要递送到信箱里;而今天,这个过程是完全自动化的。同样的技术也可以用来自动读取 ATM 机上银行支票的金额。有趣的是,最难的部分其实是查找支票上数字的位置,因为每张支票都有不同的格式。早在20世纪 80年代,杨立昆就显露出了证明原理(学者们擅长的事情)并将之应用在现实世界中的非凡天赋。后者要求实际产品必须经过严格的测试,且表现稳健。

杨立昆在2003 年去了纽约大学后,仍继续开发他的视觉网络,现在被称为卷积网络(ConvNet)。这个网络的基本结构是基于卷积的,卷积可以被想象成一个小的滑动滤波器,在滑过整张图像的过程中创建一个特征层。

图4 杰弗里·辛顿和杨立昆,照片拍摄于2000年

1986 年大卫·鲁姆哈特(DavidRumelhart)和杰弗里·辛顿发表了文章《通过误差传播学习内在表征》(Learning Internal Representations by Error-Propagation),其中介绍了当前用于深度学习的“反传”(backprop)学习算法。

深度学习的黎明和爆发

杰弗里·辛顿在21世纪头十年成为加拿大高等研究院(Canadian Institute for Advanced Research,简称CIFAR)神经计算和自适应感知项目的带头人。该项目由来自加拿大和其他国家的约 25 位研究人员组成,专注于解决机器学习的难题。

后来,另外两位图灵奖获得者蒙特利尔大学的约书亚·本吉奥,和杨立昆一起,接替杰弗里·辛顿,成为 CIFAR 神经计算和NCAP 项目的主任,该项目在通过十年评估后更名为“机器学习和大脑学习”项目(Learning in Machines and Brains)。约书亚率领蒙特利尔大学的一个团队,致力于应用深度学习来处理自然语言,这将成为“机器学习和大脑学习”项目新的研究重点。

图5 约书亚·本吉奥

约书亚·本吉奥作为 CIFAR“机器学习和大脑学习”项目的联合主任。这位在法国出生的加拿大籍计算机科学家,一直是应用深度学习处理自然语言问题这个领域的领导者。杰弗里·辛顿、杨立昆和约书亚·本吉奥所取得的进展,为深度学习的成功奠定了基础。

2012年在太浩湖举行的NIPS 大会上,深度学习领域的研究已经日趋成熟。在这次大会上,早期的神经网络先驱杰弗里·辛顿和他的学生们发表了一篇论文,文中指出,多层神经网络在识别图像中的对象方面性能非常出色。这些网络不仅比现有计算机的视觉技术更好,它们甚至已经处于一种完全不同的更高层次中,更加接近人类的表现水准。《纽约时报》刊登了一篇关于深度学习的文章,同时Facebook 宣布与另一位深度学习先驱杨立昆合作成立一个新的人工智能实验室,由后者担任创始实验室主任。

计算机协会(ACM)主席在评论这次获奖情况时说:“人工智能是现在所有科学领域发展最快的之一,也是社会上最受关注的话题之一。人工智能的发展很大程度归功于本吉奥,辛顿和杨立昆为深度学习的最新进展奠定的基础。数十亿人都在使用着这一技术。任何口袋里装着智能手机的人都可以体验到自然语言处理和计算机视觉方面的进步,而这些在十多年前都是不可能的。除了我们日常使用的物品,深度学习的新进展也给了从医学到天文学再到材料科学的科学家们强有力的新工具。”

神经网络学习的重大突破每30年就会发生一次,从 20世纪 50年代引入感知器开始,到20世纪 80年代学习多层感知器算法,再到2010 年开始兴起深度学习。其中每个阶段都经历了一段繁荣期,在短时间内取得了飞跃性的进展,随后便是较长时期的缓慢发展。但是其中一个不同点在于,随着每次复兴,兴盛时期的影响一直有增无减。最新的增长动力来源于大数据的普及,而人工智能领域的研究者们早就为这一天的到来做好了准备。