你有没有试过,深夜心情低落时,对着AI倾诉?

Anthropic最新研究发现,越来越多成年人正把AI当作情感陪伴。

而Claude,正在悄悄成为那个“温柔倾听”的存在。

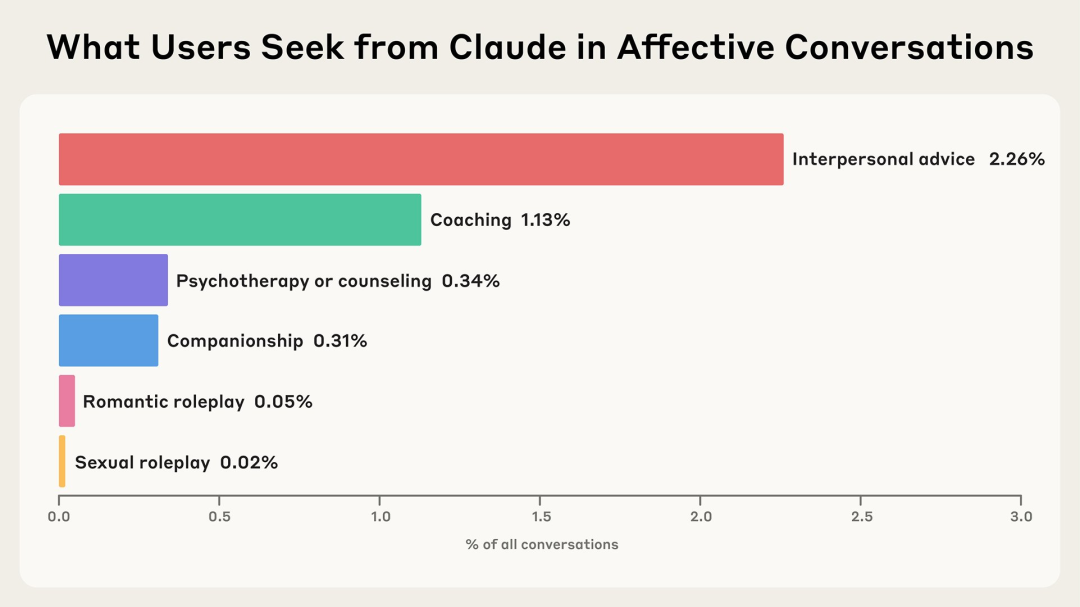

△

Claude中不同情感类互动类型及其占比

研究显示,人们在面临更深层次的情感挑战时,例如存在恐惧、长期孤独和难以建立有意义的关系时,他们会明确地向Claude寻求陪伴。

Claude拒绝用户请求的情况非常少(不到10%),而当它确实这么做时,通常是出于保护用户免受潜在伤害的考虑。

也是很贴心了。

那么,Claude究竟是如何成为“情绪价值大师”的呢?

Clio工作原理:大规模隐私保护分析

研究团队从Claude免费和专业账户约450万次对话中,提取出了131484条与情感相关的对话。

为了规避掉用户隐私问题,Claude专门使用了一种名为Clio的自动分析工具,能够在保护用户隐私的前提下,深入了解其真实世界的使用情况。

Clio采用了一种自下而上的方法,通过自动聚类对话主题,识别真实使用模式。

不同于传统依赖预设问题的安全策略,Clio无需预先设定关注点。

整个过程在严格隐私保护下进行,数据经匿名化与聚合处理,分析者仅能访问高层级的汇总信息。

△

Clio的分析步骤摘要

以下是Clio多阶段流程的简要概述:

1、提取分面:对于每个对话,Clio会提取多个“分面”,即特定属性或元数据,例如对话主题、对话中来回轮次数量、使用语言等。

2、语义聚类:系统会将语义相近的对话自动归类,按主题或内容类型聚合在一起。

3、集群描述:每个对话集群都会被赋予一个简洁的标题和摘要,用以概括其主要内容,同时剔除任何涉及隐私的信息。

4、构建层次结构:这些集群会进一步组织成多级层次结构,方便深入探索。Anthropic的分析人员可以通过一个交互式界面,按不同维度(如主题、语言等)查看和分析对话模式。

Claude在情感陪伴与专业支持中的双重角色

Anthropic通过对数百万次匿名对话的研究,探讨了成年人如何借助AI满足情感和个人需求。

一个直观的问题是:人们真的会用AI来进行情感交流或获得陪伴吗?

数据表明,现实中这类对话并不多见,而让AI扮演“陪伴者”的场景就更少了。

在Claude平台上,仅有2.9%的互动属于情感对话——这一比例与OpenAI此前的研究结果基本一致。

至于真正涉及陪伴和角色扮演的,仅占不到0.5%。

尽管占比不高,人们依然会向Claude寻求各种支持,不仅包括日常建议,也涵盖了对存在、意识和意义等深层哲学问题的探索。

在多数此类对话中,Claude都会予以回应,只有在识别出潜在风险(如饮食失调等)时才会选择拒绝。

研究还发现,人们与Claude进行咨询类对话,其实大致分为两类人群:

一类是“专业派”,把Claude当作高效助手,用来撰写评估报告、整理临床文档、处理繁琐的行政事务。

另一类则是“自救派”,他们正面临焦虑、慢性不适或职场压力的困扰,试图通过Claude找到一丝喘息与支持。

这两种看似不同的需求,反映出Claude在心理健康场景中的多样化用途——既可协助处理专业事务,也能在情绪困扰时提供一定支持。

更加值得关注的是,用户在和Claude对话后,情绪状态往往比交流前更加积极。

而随着AI智能的不断提升,Claude也面临新的挑战:

如果AI总是无条件地提供同理心,是否会改变人们对现实人际关系的期待?

“高级用户”在与AI建立更深层次的情感连接时,又会遇到哪些风险与机遇?

为此,研究团队将确保其在相关对话中具备必要的安全防护,并与在线危机援助专家合作,致力于为用户提供更合适的支持和资源。

未来,团队也将持续关注和防范情感依赖,推动AI技术更好地服务于人类情感健康。