AI的风最近刮得有些猛。

作为科技行业的“老玩家”之一,英特尔这家芯片巨头始终备受关注,而近期的焦点则被放在了“英特尔在这个AI时代究竟表现如何”的话题上。

事实上,就如同你低头看看自己各种智能设备后的感受一样,AI变革的确剧烈,但英特尔依然在最关键的智能和网络设备里占据核心位置,在AI这事儿上同样如此。

英特尔市场营销集团副总裁、中国区云与行业解决方案和数据中心销售部总经理梁雅莉在最近的云栖大会上提到,英特尔的愿景是让“AI无处不在”,“以用户的需求和业务场景为出发点,开发从云到端的全线产品组合和开放的生态,为业界提供全栈AI产品的组合和行业解决方案,加速从云基础设施到边缘,再到客户端的AI应用全场景落地。”

在会上英特尔和阿里云共同举办的一场论坛里,英特尔的多个技术和业务负责人介绍了英特尔在AI上的多个重要布局的进展。仔细观察这些布局,你会看到这家芯片巨头在AI时代的两个侧面。

第一个侧面,是它在核心芯片业务上对AI时代做出的应对。

其中,即将发布的至强6是集大成者。而这次英特尔也提前“剧透”了一下至强6的信息。

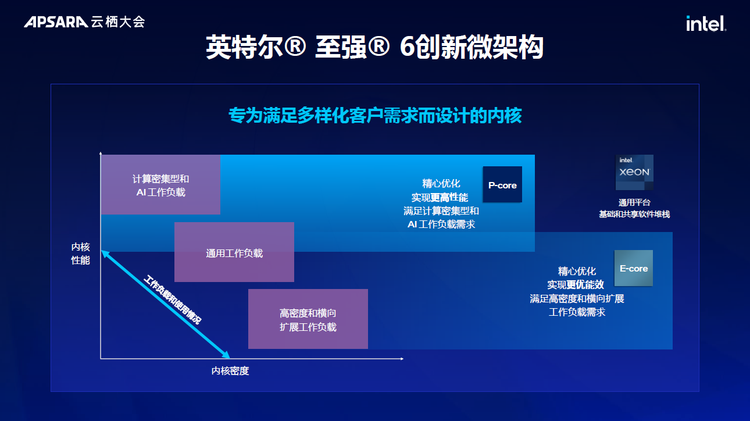

最核心的几个特点包括,双核的架构设计(性能核与能效核),专门强化过的AI推理与训练能力,在内存与带宽上的提升,为数据中心的高密度计算做的设计优化,以及更强的兼容性和多场景的适配 。

据英特尔透露,至强6性能核处理器在AI推理和训练上可以处理13B参数的模型推理任务,它内置AMX(Advanced Matrix Extensions,高级矩阵扩展),这是在CPU每一个核心内部引入的,用来加速深度学习相关应用的集成层的一个运算单元,可以极大加速生成式AI的推理。

“在基准测试中,相对于不启用AMX,启用AMX能实现性能的数倍级提升。该特性在8代实例首发,在某客户的模型训练的前置数据预处理过程中,会有大量的语料需要清洗,清洗过程主要对数据进行向量化处理,通过利用英特尔AMX指令加速能力,整体性能提升30%以上。”作为紧密合作伙伴的阿里云此次也介绍了AMX在实际客户侧的表现。

在内存带宽上,通过MCR DIMM技术提升了70%,内存通道从8增加至12,频率达到6400 MT/s。同时,网络连接数翻倍,延迟降低至8微秒,IOPS性能提升20%。此外,至强6能效核处理器在相同负载下可极大地节省功耗,对于一个包含了200个典型机柜的中型数据中心来说,机柜性能提升2.6倍,相当于在四年内节省8万兆瓦时电力,减少34000吨碳排放。

这些技术信息回答了CPU公司在AI时代扮演的角色的问题。这不是一个已经格局已定的时期,而是各种路线百花齐放的阶段,CPU有它的机会,而英特尔积累的对CPU和整个链路优化的能力会起到关键作用。

另一个侧面是一家经历了多个周期的科技公司在一个剧烈变化的当下对技术更长期的判断,以及对应的动作。

CXL是这个侧面一个有意思的代表。

CXL(Compute Express Link)是一种高速互联技术,为了解决计算设备(如CPU、GPU和内存)之间的数据传输问题。通过CXL,数据中心可以实现更快、更高效的设备协作,尤其是在处理大型AI模型时。

今天限制大模型训练和推理的一个关键因素就是内存瓶颈,模型的参数和数据集可能超过传统内存系统的容量,这就是所谓的“内存墙”问题。CXL通过共享大容量的内存资源来扩展系统的内存池。另外,CXL的初衷是解决异构计算的加速问题,而且它已经成为一个开放的互联标准,被越来越多的硬件厂商和数据中心采用。更简单、兼容性更强的硬件部署路径,对英特尔的软硬件生态建设至关重要。

“到了3.0代际,这种池化的共享可以扩展到机柜级,甚至是跨机柜、多机柜的级别。”英特尔的技术专家透露。“ CXL在AI大模型的时代下,仍然有很多规范定义了AI大模型的特性,基于这个规范大家可以各显神通,可以做创新的实践。”

根据阿里云的透露,基于英特尔的这一系列的技术创新,其单位CPU算力大概平均提升了15%左右,在内存带宽、内存频率上也实现大量提升。这让阿里云弹性计算第九代产品,与上一代相比,实现了同品类同规格组增量不增价的改进。

这些新的进展放在一起,也能逐渐看到英特尔在AI上的判断:

它要通过今天各种科技公司里少有的全栈系统化的能力,重塑计算设备之间的互联方式,最终建设一个为AI重新设计的基础设施了。