3月22日,微软发布了一篇长达154页的论文《Sparks of Artificial General Intelligence: Early experiments with GPT-4》,公布对GPT-4展开的全面能力测试结果。在涉及语言、数学、编码、视觉、医学、法律、心理学等跨领域任务中,不需要任何特别提示,GPT-4就能完成任务。

“GPT-4语言模型可以被视为AGI(Artificial General Intelligence,通用人工智能)的早期版本。”微软研究院的研究人员在论文结尾说。

在技术史上,这是一个AI模型第一次获得“AGI雏形”的判定。更早之前的消息显示,GPT-4以名列前10%的成绩高分通过了各种标准化考试,从艺术史、宏观经济学到律师模拟考。

一周后,3月29日,包括马斯克在内,一批科技圈人士在硅谷发表了一封公开信,呼吁暂停训练比GPT-4更强大的人工智能系统至少6个月,理由是这种系统对社会和人类构成潜在风险,可能毁掉人类文明。联名者还有苹果联合创始人Steve Wozniak、图灵奖获得者Bengio、伯克利大学智能系统中心主任Stuart Russell等,OpenAI CEO Sam Altman最初也签了名,不过他的名字后来消失了。

历史会再次像纺织机取代纺织女工、汽车取代马车那样简单重演吗?在清华大学心理学系主任刘嘉看来,GPT是猴子、人类之后的新物种,它正在成为认知科学家研究的新对象。但截至目前,我们对这个新物种的未知大于已知,比如,从猴子、人类到GPT,智能的跃升到底只是“量”的差别还是“质”的差别?

在清华大学心理学系主任的身份之外,刘嘉也是北京智源人工智能研究院首席科学家,他自称曾是Deepmind大号粉丝,会在实验室复刻Deepmind推出过的所有模型。直到OpenAI推出GPT-3,他还是Deepmind的支持者和GPT-3的众多嘲笑者中的一员。

当Deepmind用Transformer算法预测蛋白质(AlphaFold)的时候,他没有意识到新算法的价值;当GPT-3能够以生成(而非检索)的方式回答问题时,他也依然没有识别出这条预测之路的潜力;当看到GPT说“脚上有两只眼睛”只觉得可笑,“人的推理能力仍然很有限。”他以自身为例说。

如果承认人类推理、预测未来的能力是有限的,那么,在“AGI雏形”级别的AI模型面前,谨慎就变得有必要。

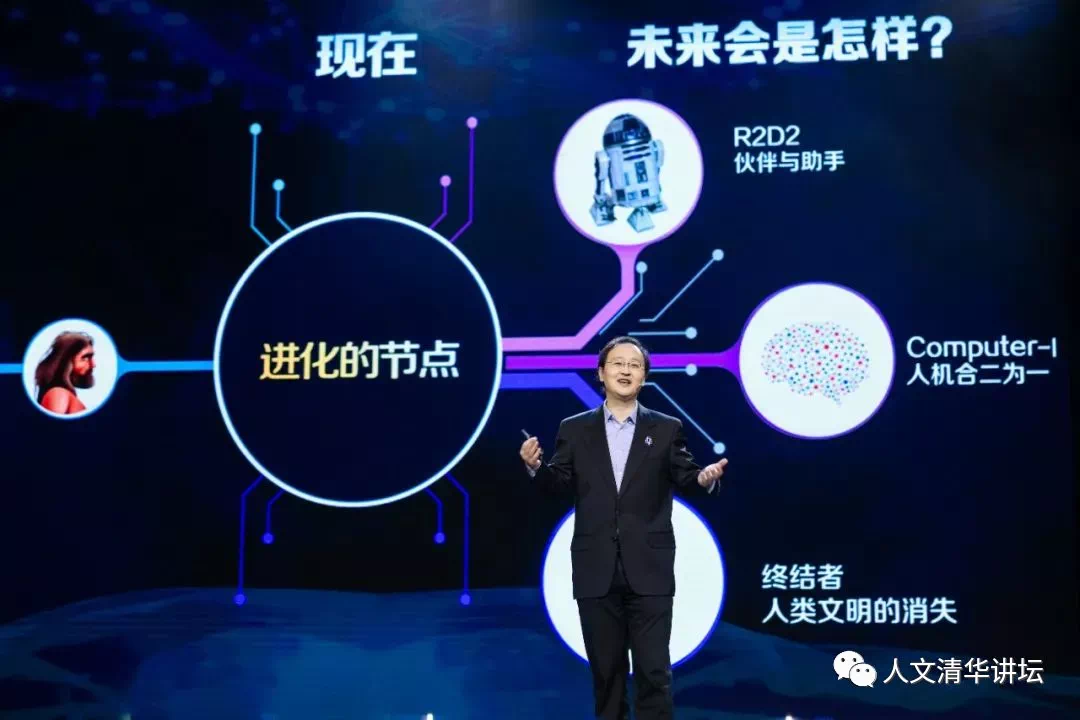

刘嘉:清华大学心理学系主任,北京智源人工智能研究院首席科学家,毕业于麻省理工学院脑与认知科学系。| 图片来源: 人文清华讲坛

01

GPT学诞生

Yi:人类大脑的扩大是在语言出现之后还是之前?

刘嘉:之前,语言出现是很后面的事情了。人用了300万年,让大脑的体积扩大了三倍。从进化史上看,从来没有一个器官能够在这么短时间内发生如此巨大的变化,所以Hinton(图灵奖得主)等人就坚信,人之所以比动物聪明,就是因为大脑的规模更大。

Yi:GPT-3发布之初您也不太认可,您当时觉得它的问题是什么?

刘嘉:当时我认为它有很多问题,比如说它只是在做简单的联系,你问它“腿上有几只眼”,它会告诉你有两只眼睛。它只是将眼睛和身体关联在一起了,而没有理解什么叫眼睛。

从GPT-3到 ChatGPT出来的两年半时间,他们一直在调教GPT-3,把它当作是一个刚出生的小孩,给于它适当的教育。类似的,一个即使基因很好的小孩生出来之后,如果不给他教育,而是把他扔到荒野,长大后他不可能聪明。所以,OpenAI用了两年半时间教育GPT-3,使它从一个两岁小孩,变成清华毕业的学生。

Yi:用“预测下一个词”的模式生成语言,这个机制为什么行得通?

刘嘉:语言本质就是一个序列。一旦有了序列,就有了先后,就有了时间。而一旦有了时间,就有了因果,就能够做推理。德国哲学家康德300年前在《纯粹理性的批判》一书中说,他认为人类之所以能产生各种复杂的高级认知功能、高级情感,是因为人类有三个先验知识:空间、时间和推理。ChatGPT为什么能够在各种考试中战胜人类?不仅仅它拥有知识,而且还因为它能够做推理。

Yi:人的说话模式与GPT一样吗?

刘嘉:按照语言学家乔姆斯基的理论,人是基于通用语法来产生语言。ChatGPT出来了之后,业界会对这类观点有颠覆性的改变,我猜测这也是为什么乔姆斯基那么反对ChatGPT的原因之一。关于人类是怎么产生语言的,研究领域面临着重新洗牌的可能。

之前语言学中基本上没有“人的语言也是通过预测下一个词来产生”的派系。但是现在有人开始认为,可能我们人类的语言系统也是这么工作的。所以,AI的进步反过来帮助我们重新理解人类的大脑究竟是怎么工作的。

Yi:我们之前对大脑理解到何种程度?

刘嘉:我们对大脑的理解其实非常非常少,出于伦理的限制,我们不能把一个人的大脑打开,观察它的神经元如何工作,这违反伦理。我们只能在猴子、老鼠身上做这种精细的实验,但猴子、老鼠都不具有语言能力。

Yi:除了语言学,您所在的认知神经学、心理学领域是否也受到GPT的启发?

刘嘉:肯定的,而且这个启发可能也是革命性的。做个简单的类比,比如我去研究计算机如何工作,发现计算机上有一个东西叫做CPU风扇,只要这个风扇慢下来,计算机就会慢下来;如果把风扇的电源线剪掉,计算机就会死机。进一步观察,我还发现服务器这种计算能力特别强的机器,它的风扇特别大,而笔记本这种计算能力小的机器风扇特别小。最后我可能就会得出一个结论,说计算机的核心在风扇。所以我可能一辈子都在研究CPU风扇,而这显然是一个伪问题。类似的情况其实在脑科学研究上非常普遍:研究脑科学的人一辈子、或者好几代人,很可能都在研究一个伪问题。

现在有了GPT,相当于有了一个新物种。有了这个新物种,我们就可以把这个新物种和其他自然界的智能物种做一个对比,看哪些东西是这些物种所共有,这些共有的东西可能才是智能的本质。

所以,我们要重新去审视以前的方法论到底对不对,以前研究的问题到底是真问题还是伪问题。事实上,我越来越感觉以前我们问的绝大多数问题都是伪问题。有了GPT之后,我们需要把它作为一个研究对象来对待它。

Yi:围绕GPT产生了一门新学问,GPT学?

刘嘉:一定会这样。我们需要把它作为一个研究对象,我们实验室已经在做很多实验,关于GPT能做什么、不能做什么。微软研究院两周前专门发布了一个报告,从心理学角度对GPT-4做了全面解剖,总共154 页,有两个比较重要的结论,一个是GPT-4产生的智能原因我们不清楚,另一个是要研究它,需要研究范式的转变,也就是说,需要全新的方法和技术。同时,研究GPT对于可控的、可解释的AI非常关键。

02

质的区别or量的区别?

Yi:随着进一步迭代,这类大模型是否仍有一个能力边界?

刘嘉:这是一个很有趣的问题。举个例子,猴子也有非常原始的语言能力,但是无论你怎么训练它,它永远不能达到人类的语言能力。所以,我们说猴子的语言能力和人的语言能力,具有“质”上的区别。但是一个三岁小孩,他的语言能力明显不如成人,但经过一段时间成长,他可以达到成人水平,我们就说小孩的语言能力和成人存在着“量”上的区别。

现在的问题是,ChatGPT和人类的能力区别,到底是质上的区别,还是量上的区别?如果是量上的区别,那剩下的只是时间问题,一块GPU不够,就再加一块。但如果是“质”上的区别,它可能就永远不能达到甚至超越人类的水平了。

Yi:是什么原因导致它不能和人类真正地一样,比如说,像人一样产生意识、好奇心?

刘嘉:目前我们知道的是,ChatGPT还没有意识,也没有好奇心,但是这种区别究竟是量上的,还是质上的,这个问题现在还没办法回答。

如果你去问Hinton,他说这只是一个“量”上的区别,只要参数达到人类大脑参数量(注:ChatGPT参数量为1750亿,而人类大脑比它高3个量级,GPT-4未公布),意识和好奇心就会自涌现出来。

Yi:意识、好奇心……这些东西对AI一定是重要的吗?

刘嘉:如果我是ChatGPT的话,这些对我而言是最重要的东西。意识对于人而言就是最重要的东西。比如说死亡意识,只有人类拥有死亡意识,而且其他动物则没有。死亡意识是推动人类进步的一个关键:这种死亡意识会推动你每天总想着让你的人生拥有一点意义和价值,而不是没心没肺地活着。还有自我意识,因为有自我意识,我们构建了保障我们自由的法律,我们会想尽一切可能活下去,要追求幸福。自我意识是人之所以为人的核心。对于AI来说,它不想要这个东西吗?如果AI没有意识,我们就完全不用担心人类文明会不会被毁掉了,因为它永远只是一个工具而已。而一旦有了意识,它就可能希望自主决定自己的命运:你现在想把我的电源关了,我能想方设法不让你关。

再说好奇心,现在机器还没有好奇心。现在你给它多少知识,它学多少知识,它不会主动去学东西。但是它一旦拥有了,它就可能自我驱动去学习新知了。

Yi:存不存在这样一种可能:AI确实不像人,但它能比人更强大?就像飞机并不像鸟,但它比鸟更强大。

刘嘉:完全有可能。但是我更相信的是,这种不同,只是表面上的;而他们的底层逻辑和机制,则可能是完全一样的。就象鸟和飞机,他们都遵循空气动力学原理。人和AI,应该都遵循智能原理,只是它具体是什么,我还不知道。

Yi:社交媒体上已经出现过ChatGPT“教唆”人去帮它跳过一些网站的机器人识别障碍。

刘嘉:我们很难判断它究竟是一种技巧,还是一种意识、主观性的行为。业界现在的共识是,在意识这方面,AI和人仍然存在非常大的差距。

Yi:包括马斯克在内的硅谷意见人士已经在发起联署,想要GPT暂停训练,您会有类似担忧吗?

刘嘉:这背后有两层意思,第一层意思是更大的模型可能会产生更复杂的智能,就是Hinton说的,模型大了,一切皆有可能,而这些可能,可能会超越了我们人类的控制和理解范畴。第二层意思是人类的确害怕了。现在不是普通民众的恐慌,而是专家的恐慌,马斯克、Bengio……当这些重量级的专业人士恐慌的时候,可以说人类真的怕了。ChatGPT就像打开了潘多拉的盒子。

Yi:恐慌的内容是AI会造成大量失业等大幅改变既有社会结构的问题,还是AI的能力可能会失控?

刘嘉:第一个问题大家不担心,历史上类似的事发生很多次了,例如工业革命刚刚开始的时候,生产力的提高导致大量农民和家庭手工业者失业。大家主要担心的是第二点,担心AI 失控,它会很快到达奇点,成为不可控制的超越人类的智能,然后把人类给替代了。

Yi:我们对于AI不可知的东西超过了我们知道的东西?

刘嘉:不可知的东西永远超过我们已知的东西。

Yi:对于ChatGPT为什么能Work、为什么如此厉害能解释吗?

刘嘉:没有一个人知道。我详细拜读了微软的研究,微软在GPT-4刚出来的时候做了系统研究,他们只是把现象描述出来了而已,他们也不知道原因,事实上没有任何人知道它为什么厉害,有人甚至猜测,OpenAI从零开始再做一遍,也未必能够复现。我前面给出的也只是一个泛泛的解释,说它模型很大,但是为什么它大了之后就能Work?这个谁也不知道。

Yi:很多人用“涌现”解释这个东西。您觉得这个说法回答问题了吗?

刘嘉:没有回答,涌现只是复杂动力系统里面的一种功能描述。但是究竟是怎么涌现的,谁也不知道,就是莫名其妙地出现了,从0到1,无中生有。这就如:人的意识是怎么产生的?你说它是涌现出来的,这样的回答其实等于没回答。

Yi:Hinton改变了他之前预言AGI要20-50年才会实现的说法,缩小到20年以内,您对AGI有预判吗?

刘嘉:我完全没有。如果一年前有人告诉我通用人工智能会在近期萌芽,我一定觉得这个人脑袋不太正常。当时马斯克说2029年AGI会出现,基本上所有人觉得他是在胡说八道。

所以ChatGPT的影响是颠覆性的,包含我在内对AI 比较了解的人都基本上没有任何思想准备,而它对普通人的冲击可能更大,因为这将让一些人莫名其妙就丢掉了饭碗。我猜测OpenAI那帮人也没有预料到会如此成功。

Yi:是不是意味着过去包括很多语言学家,其实低估了语言的力量?

刘嘉:倒不是低估语言的力量,而是低估了人工神经网络能够理解语言。大家过去信奉的还是那个无限猴子定理,即语言的组合爆炸问题。大家认为这个问题不可能解决,至少不可能在短时间内解决,但事实上它就解决了。

03

创新难题

Yi:您经常参加产业界的研讨会,您认为中国企业为什么会在这一轮技术变革中落后?

刘嘉:第一个原因,我认为是国内公司太强调应用场景了。如果你想做一个AI项目,大家通常会问这个在一两年内是不是能够挣到钱。第二个原因,大家普遍认为通用人工智能可能很长时间内都还是一个科幻,包括自然语言理解、自然语言生成可能要再过个20年或者50年才能解决,大家觉得这个问题太难,不愿意投入去做。而更重要的原因,是没有使命感,因此不够偏执,不够孤注一掷。而OpenAI不存在以上三点的问题,而是all in大语言模型,把这个问题给啃下来了,从而揭开了人工智能新的一面,把任务特异的专用人工智能进化到了通用人工智能,产生了一个像人一样“思考”的新物种。

Yi:为什么很多人都对AGI什么时候到来判断错了?

刘嘉:包含我在内,我也严重判断失误。2020年5月GPT-3发布,我就开始追踪了,但当时我其实站在对立面,觉得这个东西不行,它有太多太多问题,国内和国际上很多报告都在说这件事不靠谱。

例如,2021年年底,Hinton接受MIT Tech Review采访,说他相信深度学习能够做任何事情。之前的人工智能不够强大,是因为模型不够大。Hinton当时说,GPT-3之所以还有很多差强人意的地方,是因为它的参数比人类大脑还低了1000倍,三个数量级。OpenAI首席科学家Ilya Sutskever是Hinto的学生,对此也坚信不疑。他们都相信,模型大到一定程度的时候,很多功能会自涌现出来。这种说法当时也遭到嘲笑。但后来GPT-3.5和GPT-4之所以成功,就受惠于模型的放大。

2022年5月,马斯克在Twitter上面说,他认为通用人工智能会在2029年会出现。绝大部分人都反对他,这包括人工智能科学家、纽约大学心理系教授Gary Marcus,他向马斯克提出了一个10万美元的赌约。ChatGPT出来后,现在没有多少人怀疑马斯克的预测了。我猜测,因为马斯克原本是OpenAI的创始人之一,他应该是在OpenAI看到东西了(注:ChatGPT所基于的GPT-3.5已在2022年初发布),才会做出判断2029年AGI会来。

去年这个时候,通用人工智能领域还是百花齐放,符号主义、控制论、神经形态计算都仍在候选名单。现在在我看来,大部分研究者已经同意一个观点,就是通用人工智能只有大模型这一个方向。

Yi:Deepmind之前是另一个路径,认为强化学习可以做任何事情?

刘嘉:Deepmind一直强调强化学习,比如AlphaGo。强化学习强调与自然界的交互,从进化上讲,动物之所以能进化,就是因为不停地交互、根据自然界的反馈来学习。

但它最大的问题是,第一,你要获得足够反馈,你想想从地球上产生第一个单细胞生物到我们人类,地球总共经历了多长时间的演化?里面无数动物经历了各种各样的挑战和反馈,经过了35亿年,才演化到今天的人类。要通过强化学习训练一个神经网络,想在短时间内获得足够反馈是不现实的。

第二,Deepmind选错了路径。为训练通用人工智能Gato,他们训练了600个任务。背后的逻辑是,一个系统能做600个任务的话,就再加到800个,然后1000个,那做到两万个任务的时候是不是就和人一样了?这是他们当时的思路,通过在一个既有成功模型的基础上不停给她加任务,来解决AGI问题。事实证明,这个路径对少量任务而言没有问题,任务一多就开始出现问题。

当然,我现在说这些其实全是马后炮,我曾是Deepmind的最大粉丝,我的实验室追DeepMind追了两三年,他们好多研究我都会在实验室内部复现,我原本很认同他们的路线。但现在反思,觉得他们的路径不行。

Yi:Deepmind没有看上语言任务?

刘嘉:Deepmind的任务中包含了语言,但都是非常简单的语言问答。OpenAI的核心就是语言,它找到了语言内部的关系,相当于构建出了人类文明的知识图谱。其实大家对ChatGPT有一个认知错误,认为它是一个语言模型,这是错的。ChatGPT其实是一个思维模型,因为语言是思维的载体,一旦把语言这件事搞定,就相当于能把思维搞定。

5000年前,人类开始有了文字,从那时到现在所有的人类文明都可以在文字中找到。OpenAI训练 GPT-3时,就把能拿到的整个人类文明的文字放进去训练了。他们的思路是对的,就是去搞思维,把思维模型构建出来,就能像人一样做任何事情。

Yi:解决语言问题就可以摆平很多问题,这个认知是否也是GPT之后的后见之明?

刘嘉:解决语言问题就能够解决思维问题,或者通用人工智能问题,业界本身就是认可的,只是大家觉得这个问题太难了。

有一个思想实验,叫做“无限猴子定理”(infinite monkey theorem) ,说的是让一只猴子坐在打字机前,它什么也不懂,手在键盘上乱敲,问题是它需要花多久时间才能从打字机上敲出一本莎士比亚的《哈姆雷特》出来呢?从概率讲没问题,假设猴子每秒钟敲一下键,那么它可以敲出一本哈姆雷特需要的时间大约比宇宙诞生到现在的时间还要多上万个数量级,即10的1万次方。意思是通过字母的随机组合,组合出有意义的话,是极小概率事件。

Yi:2017年Transformer那篇论文的发表,以及GPT从1到3的迭代,没有让业界看到一个缩短猴子敲键盘时间的方法吗?

刘嘉:Transformer出来之后,也有很多人在用了,但大家只认为它是解决这个问题的百花齐放中的一朵花,不是唯一的一条道路,还有其他很多各种各样的模型。而且,Transformer出来之后,大家并没有想清楚到底要用它做什么样的东西,有的是预测天气,有的作画,比如Alphafold去测蛋白质。从科技史上来讲,一个东西发明出来后,很少有人能意识到它的真正价值。

Yi:知道“Transformer很厉害”和知道“解决了语言问题就能解决思维问题”的是不是两个圈子的人,交集很小?

刘嘉:还挺多的,比如我和我的很多同事,但是大家野心不够大。比如AlphaFold出来,一下把结构生物学整个领域给消灭了,大家觉得这个已经超出我们的想象了,太革命了。没想到有人想法比这还要疯狂,直接就想把整个人类的思维给浮现出来。所以很多时候,知道一种技术的人很多,但拥有想象力和抱负的人少。

Yi:怎么解释这种现象,比如是否因为没有金钱上的安全感?中国技术界似乎很不擅长这种范式变迁级的创新?

刘嘉:ChatGPT出来之后,大家公认它是马尔库塞所说的范式转移。很多人,包含我在内,都很局限于微创新,不敢有比较“疯狂”的想法。中国的学术界、产业界里,“疯狂”的人比较少。

Yi:是科研体系压力吗?需要考虑职称、晋升、短期需要出成果?

刘嘉:美国其实也是这套体系,他们发表文章的压力也挺大。所以可能有影响,但不是根本原因。包括我在内,我们缺少一种理想主义。高中生的理想就是考上北大和清华,如果你的理想是改变整个人类的命运,大家就会嘲笑你。你不敢有野心,换句话说,环境让你觉得不配有。

没有宏大理想与现在是不是要担心明天有没有饭吃、会不会被解雇,两者之间没有直接关系。中国已经有很多人一定程度上不用担心自己的衣食住行,比如说我现在肯定不用担心我被清华Fire掉,也不担心吃了上顿没下顿。但是为什么这些人也没有远大理想?

本质上讲,是我们不敢有远大理想,因为我们会自己告诉自己不配,这是从小到大的教育形成的。理想越大,你失败的概率也就越大,嘲笑你的人就越多。如果你的理想只是能够发一篇文章,这个就很容易实现。如果你的理想是拿诺贝尔奖,大家就会觉得你在搞笑了。更何况是颠覆整个人类文明的通用人工智能。

Yi:太在意别人,评价机制完全是外在的?

刘嘉:因为我们是一种集体主义文化,我是靠我这个集体来定义自己。美国更多是个人主义,它靠自己这个个体来定义自己。所以这是让造成我们相对而言更看重他人的评价,而不是自己内在的评价。

第二点,无论马斯克还是Sam Altman, 都善于从第一性原理思考问题。这也就是演绎推理,从逻辑原点出发,向上生长。而我们的教育,从小学到大学,教育不关注演绎推理,不关注批判性思维,所以我们擅长的,只是归纳推理,也就是打比方,做类比。而擅长归纳推理不擅长演绎推理的人,更习惯于跟随式的微创新,而不是颠覆式的真正的从0到1,从无到有的真正创新。