目前我使用的还是ChatGPT 3.5版本,和本文开头的维基编辑一样,我发现ChatGPT经常满嘴胡说……它不仅经常煞有介事地捏造一些子虚乌有的事实,当你指出它的错误后,它还会瞬间改变自己的回答,尽管再次的回答往往还是错误的。

这对于一个编辑来说无疑是很不爽的体验——这时候维基百科就显示出了它与人工智能的不同,尽管在反复的编辑中某些词条自然存在部分争议,但依照“N.P.V.O”的原则,关于事实陈述部分要比ChatGPT靠谱很多了。

本文来自微信公众号:利维坦 (ID:liweitan2014),基于创作共享协议(BY-NC),由作者Jon Gertner发布,编译:南瓜大王,校对:tim,原文标题:《真相时刻:维基百科会不会在协助AI不断完善的过程中自取灭亡?》,题图来自:视觉中国(维基百科创始人之一Jimmy Wales)

文章摘要

本文探讨了维基百科在人工智能时代中的未来前景,以及与智能聊天机器人的关系。维基百科作为一个可靠的知识来源,面临着智能聊天机器人的竞争和挑战。虽然智能聊天机器人在语言交互方面有优势,但维基百科的准确性和内容质量仍然是其独特的优势。

• 维基百科的准确性和内容质量相对于智能聊天机器人更具可靠性。

• 智能聊天机器人在接受训练时需要依赖维基百科等数据库,但其回答的准确性有待提高。

• 维基百科与智能聊天机器人可以通过插件的方式结合,提供准确性和流畅性的知识服务。

2021年初,当一位维基百科(Wikipedia)的编辑首次试用ChatGPT 3时,他发现这个语言模型错误百出——它会随意编造事实,胡乱引用文章。但同时,他也意识到了这个工具的巨大潜能,并深信在不久的将来,它将取代他深爱的维基百科。这位编辑为此写下了一篇名为《维基百科之死》(Death of Wikipedia)的文章。

© Mashable

如今两年的时间过去了,ChatGPT已经更新到了版本4;维基百科也在今年1月度过了自己22周岁的生日,那么,二者目前究竟存在一种怎样的关系呢?

新闻记者、作家乔恩·格特纳(Jon Gernter)深入探讨了这个问题,并在《纽约时报》上发表文章:《真相时刻:维基百科会不会在协助智能聊天机器人不断完善的过程中自取灭亡?》(Moment of Truth:Can Wikipedia help tech A.I. chatbots to get their facts right—without destroying itself in the process?)

回顾维基百科的历史,我们仿佛回到了网络的黄金年代:那时候,每个人,只要能联网,就能免费学习和分享所有人类的知识。

现如今,维基百科上的文章总数已经超过了6100万篇,由334种不同的语言书写。它长期在访问量最大的网站排行中榜上有名,并且,与同样上榜的Google、Youtube与Facebook不同,维基百科始终拒绝任何广告,只通过接受捐赠获取资金。

此外,它所有的贡献者都不收任何报酬——而这个群体保证了每分钟345次的编辑量。

如今的维基百科早已不仅仅是电子版的百科全书,而成为了将整个数字世界粘合在一起的知识网,为人们提供了一个可靠的信息来源。我们从Google/Bing/Alexa/Siri上搜索、了解到的知识大部分都来自维基百科,油管也使用维基百科来打击谣言。

而智能聊天机器人当然也不例外,在其接受训练的过程中,维基百科起到了至关重要、甚至可能是最关键的作用。

西门菲莎大学(Simon Fraser University)的研究员尼古拉斯·文森特(Nicholas Vincent)认为,没有维基百科就不可能有强人工智能,但他也认为,ChatGPT一类大语言模型的流行可能会导致维基百科的消亡。

在今年3月召开的一次大会上,人们探讨了人工智能对维基百科带来的威胁。编辑们的心情是喜忧参半的:他们既认为人工智能可以协助维基百科快速发展,又担心人们会越来越倾向于选择ChatGPT而不是维基百科来回答问题——比起维基有点儿古板生硬的词条,ChatGPT的回答显然更通俗易懂、自然流畅。

基于大会探讨的结果,一个共识性的呼吁是:“我们希望身处于一个全部知识是由人类生产和建构的世界。”但现在,是不是已经有点太迟了呢?

其实,早在2017年,维基媒体基金会的社群及其志愿者就在探讨如何进一步发展,在2030年实现永久性保存、分享世界知识。彼时,他们就注意到了人工智能的出现是如何改变知识的收集、组合和整合方式的。

维基百科在发展过程中遇到的挑战

除开维基百科,如今的大语言模型还广泛吸收来自Google patent database(谷歌专利数据库)、政府文件、Reddit上的问答、线上图书馆以及海量的线上新闻作为信息来源;不过,西雅图艾伦人工智能研究所(Allen Istitute for AI)的计算机科学家杰西·道奇(Jesse Dodge)认为,维基百科的贡献是无与伦比的,这不仅是因为它在用于培训大语言模型的数据总量中占到了3%~5%,更因为它是最大的、最经过精心筛选的数据库之一。

如今,维基百科的编辑们就AI与维基百科关系的热烈讨论,有点儿类似10年之前,他们就谷歌和维基百科之间关系的探讨,那时候的结论是,谷歌和维基百科互惠互利,和谐共生:维基百科使得谷歌成为了更好的搜索引擎,而维基百科也从谷歌那里获得了大量的流量。

当然,与谷歌及其他搜索引擎保持紧密关系,也给维基百科带来了一些存在危机:要是问谷歌,俄乌冲突是怎么一回事?它会引用并简要总结来自维基百科的文章内容,而读者往往更喜欢谷歌的答案,而不会去顺藤摸瓜阅读背后超过一万字并带有400个脚注的维基文章。

进一步,这会导致普通人过于简化理解我们的世界,也会影响维基百科招募到年轻一代的内容贡献者。

2017年的一项研究表明[1],人们对维基百科的访问量确实在下降。而且,智能聊天机器人的出现更是加速了这一进程。

维基媒体基金会机器学习研究小组的带头人阿隆·哈尔法克(Aaron Halfaker)表示,搜索引擎在提供简要答案的同时至少还会贴出来源链接,帮助人们回到维基百科的页面;而大语言模型只会把信息整合成流畅的语言,没有引用、没有依据,人们无从知晓答案的来源。这使得人工智能成为维基百科更难缠的对手——它可能更有害,而且很难与之竞争。

维基百科自身的缺陷及解决措施

当然,维基百科远不是尽善尽美的:首先,在4万名活跃的英语编辑中,有80%是男性,75%是美国白人男性,这导致维基百科在性别和种族方面的内容存在一些偏差。

其次,维基百科的文章可信度也不是稳定不变的:佐治亚理工学院(Georgia Institute of Technology)的教授艾米·布鲁克曼(Amy Bruckman)认为,在维基百科上,一篇经过上千人编辑的长文质量相当有保证,而一些短文却很可能出错甚至完全是垃圾。

© Wikipedia

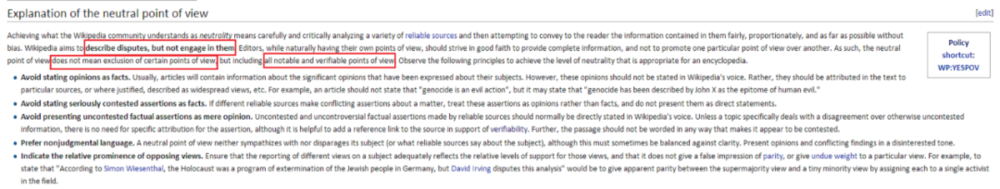

这使得编辑需要旷日持久地与谬误作战:其中有经验的会出手编辑包含一些缺乏事实依据或无法验证真假的文章;此外,在编辑守则中,内容编辑也被要求保持“N.P.V.O”——即“Neutral Point of View”(观点中立)。

人工智能工具的问题及解决方案

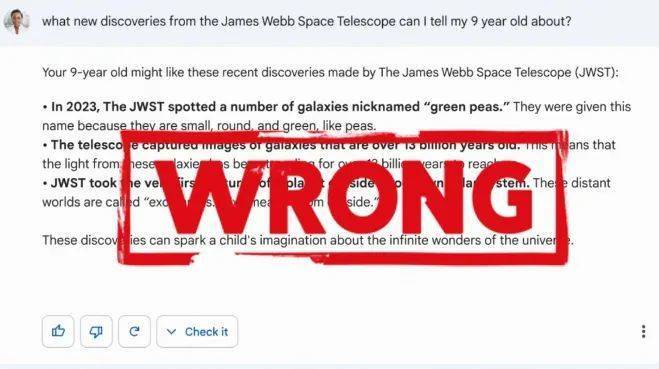

与之相对,对于智能聊天机器人来说,追寻真理之路甚至更为艰险[2]:就像ChatGPT会随意编造事实,胡乱引用不存在的文献(术语叫“hallucination”虚假信息);会过度简化一个复杂事实,例如分析俄乌冲突;也会乱给医学建议……

今年4月,斯坦福的科学家检验了4种内置AI工具的搜索引擎:Bing Chat,NeevaAI,perplexity AI和YouAI,发现它们生成的答案只有差不多一半能经得起事实的检验[3]。

© MobileSyrup

这是为什么呢?原因很简单:聊天机器人的目标不是追求绝对的真理或准确性,而是尽量根据给定的上下文和概率来产生合理的回答[4]。这种选择可能基于统计数据和语言模型,因此不是百分之百准确的。

难道答案的准确性不应该是研发、培训智能聊天机器人的公司首要追求的目标吗?对于公众来说,这几乎是个毋庸置疑的问题。然而,据计算机科学家、前谷歌研究员玛格丽特·米切尔(Margaret Mitchell)爆料,在目前商业竞争白热化的阶段,比起真实可靠,公司更在意尽快向公众推出旗下的AI产品。(顺带说一句,米切尔正是因为批评谷歌在这个领域研发方向的问题而被解雇的。)

不过,米切尔也相信前景是光明的,她已经看到使用优质信息接受训练的模型在提高准确性方面显著的提升。只是,目前AI产品的数据训练方法是“放任自流”式,即不管好的坏的就把尽可能多的信息喂给模型,设想是输入的信息越多,输出的信息质量就越高;而不是反过来——全部输入优质信息,得出优质信息。

此外,市场竞争也有助于智能聊天机器人的自我完善,例如,OpenAI与许多商业公司都有合作关系,这些公司非常注重答案的准确性。另外,谷歌公司研发的人工智能系统与医学界的专家保持了紧密合作,进行疾病诊疗方面的探索。

相较以前的版本,ChatGPT4在提供涉及“事实内容”的回答时已经有了显著进步,不过,离它能准确地回答复杂的、多层面的历史问题,还有很长的路要走。对这样的智能聊天机器人来说,准确性与创造性、流畅性之间永远存在着张力。而开发的目标,绝不仅仅是让它们能“反刍”接收知识,而是需要看穿知识的模式,并用通俗易懂的语言告诉使用者。

目前二者的合作现状

6月底,记者试用了维基媒体基金会为ChatGPT开发的插件。

ChatGPT4目前拥有的全部知识截止于它受训结束的时间:2021年9月;而这个插件可以让它接触到迄今为止的所有信息:这使得用户可以同时享受到这两种工具的带来的便利:来自维基百科的知识具有准确性和时效性,而智能聊天机器人能用流畅、自然的语言将其输出。同时,ChatGPT也会列出信息来源——维基百科的页面。

维基百科也在内化一些人工智能模型,以更好地帮助新用户,或协助编辑工作。但目前,维基的社群还是比较抵触完全由人工智能编辑的文章;而编辑们也非常担心,面对强大的无休无眠的对手,面对能瞬时生成海量内容的人工智能,人类编辑在内容审核方面付出的努力是否只是螳臂挡车,终会一败涂地。

按照目前的情况来看——任何站到人工智能对立面的举动都是不理智的,一个很可能出现的场景是:像维基百科一类的组织必须努力适应由人工智能创造的未来才可能得以存续,而不是妄想对其施加影响甚至出手阻拦。

当然,许多接受采访的学者和维基编辑也认为,人工智能制霸之路不会是摧枯拉朽的,它将面临重重阻碍:

首先是社会性的:欧盟议会目前正着手制定一系列法律条文和规章制度,来规范对人工智能产品的使用:例如强制科技公司标明由人工智能生成的内容;公开人工智能受训的数据;以及标明信息来源,不可未经授权盗用其他网站、数据库资源等。

其次是技术上的。事实上,文章一开篇已经强调,如果没有维基百科、Reddit社区提供的海量数据,大语言模型根本无从接受训练,而人工智能的研发公司完全清楚这些数据库的重要性,这就给了维基百科等网站一些谈判的筹码。

此外,今年5月底,一些人工智能研究员还合作发表了一篇论文[5],探讨新的人工智能系统是否能只靠人工智能模型生成的知识来发展自身,而完全不使用人类生成的数据库接受训练。结果,研究者发现这会导致一种系统性崩溃——称为“模型崩塌”(Model collapse):使用人工智能合成的数据可能会导致混乱,因为它们可能不准确或不真实,进而会对下一代模型的训练数据集造成负面影响,使其对现实世界的认知产生偏差。

而维基百科的插件可以避免这一情况发生,但如果在未来,维基百科上充斥着由人工智能生成的文章,那么问题同样会产生:新一代的语言模型会陷入自说自话循环论证的状态。

最终,这项研究证明了,真人交互产生的数据的价值对未来大语言模型的发展不可估量,这对维基百科的编辑们来说是个振奋人心的消息。至少一段时间之内,人工智能还需要我们,需要我们人类让它变得可信而有用。

不过,这又涉及到一个叫做“结盟”(alignment)的理论概念,即假设人工智能符合人类最大的利益。保证人工智能与人类站在同一边,既是巨大的挑战,也是研发人工智能的首要任务。

而真人的好处是,人性使得人类天生就具备一些形成同盟的条件:例如一些人乐于分享高质量的教育资源的动机,恰好符合另一些人的需求。作者最后采访了一位维基百科的英文编辑杰德(Jade),她提到知识分享是自己的人生信条:她每周会固定花10~20个小时编辑维基百科。

目前,她致力于编辑一条关于美国内战的条目,其一年的阅读量已经超过了484万次,她的目标是继续完善这篇文章,直到获得维基百科“精选”的认证——这是一种极为珍惜的认证,在维基百科的英文版中,仅仅有0.1%的内容有资格得到这项认可。

最后,记者问及杰德是否认为人工智能会完全取代她的工作,杰德回答,她是个乐观主义者,相信至少在本世纪内,机器人不会完全替代人类来编辑维基百科。

然而记者本人就没有这么确定了,毕竟,根据他自己与ChatGPT聊天的经验,尽管在信息交换的准确性和细节方面人工智能做得还不够完善,但人机交互的体验已经足够吸引他了,一切都是如此轻松。