通信世界网消息(CWW)智算中心以数据为资源,以强大的计算力驱动AI模型对数据进行深度加工,通常注重计算设备的配置和性能,以提供高效的计算服务。它不仅承载着算力、算法、数据这三大智能要素,而且还是释放算力价值的现实体现。值得注意的是,算力中心与数据中心在功能上有所区别,前者更注重提供高性能计算能力,而后者则更注重存储和处理大规模数据。

中国智算中心概况及分析

规模分析

目前,智算中心已成为数字经济高质量发展的重要支撑,人工智能在互联网、金融、政务、电信和制造等领域的应用渗透度明显提升。人工智能技术将更加深入地应用到行业场景中,而智能算力将进一步带动产业发展,成为拉动GDP增长的关键力量。

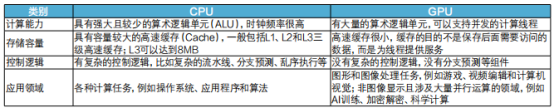

当前,各级政府、运营商、互联网企业纷纷启动智算中心建设计划,全国已有超过40个城市布局智算中心。在行业应用需求驱动和政策持续引领下,智算中心产业链有望整体受益。在智算中心中,主要应用CPU和GPU芯片进行计算,它们之间的差别如表1所示。

表1 智算中心CPU与GPU对比

2022年2月,“东数西算”工程正式拉开了构建全国一体化大数据中心体系的大幕。随着八大国家算力网络枢纽节点建设方案均进入深化实施阶段,全国数据中心机架规模逐步增长。受“新基建”、数字化转型及“数字中国”远景目标等国家政策促进及企业降本增效需求的驱动,我国数据中心市场开启高速增长模式。此后,随着各地区、各行业数字化转型的深入推进,我国数据中心市场持续保持增长态势,至2023年市场规模达到2470亿元。

在国家政策引导下,产业积极响应,加快算力基础设施建设,各类企业也纷纷加速布局。国家数据局发布的数据显示,截至2023年底,全国在用数据中心机架总规模超过810万标准机架,算力总规模达到230EFlops(EFlops指每秒进行1018次浮点运算),我国算力基础设施建设取得显著成效(如图1所示)。

图1 中国数据中心在用机架数量及增长情况

政策分析

2023年10月,工业和信息化部等六部门印发的《算力基础设施高质量发展行动计划》对我国的算力、运载力、存力建设和应用赋能做出了目标指引。其中提出,到2025年算力规模超过300EFlops,智能算力占比达到35%;存力方面,规划存储总量超过1800EB,先进存储容量占比达到30%以上。此后,上海、深圳、北京等重点城市和地区也结合本地需求制定了相关政策。2023—2025年中国算力基础设施发展指标如表2所示。

表2 2023—2025年中国算力基础设施发展指标

2023年12月,国家发展改革委、国家数据局等发布《深入实施“东数西算”工程加快构建全国一体化算力网的实施意见》(以下简称《实施意见》),提出到2025年底,综合算力基础设施体系初步成型。《实施意见》从通用算力、智能算力、超级算力一体化布局,东中西部算力一体化协同,算力、数据、算法一体化应用,算力与绿色电力一体化融合,算力发展与安全保障一体化推进等“五个统筹”出发,推动建设联网调度、普惠易用、绿色安全的全国一体化算力网。

《实施意见》明确,强化“东数西算”规划布局刚性约束,国家枢纽节点外原则上不得新建各类大型或超大型数据中心,进一步推动各类新增算力向国家枢纽节点集聚,将国家枢纽节点打造成为国家算力高地。此外,地方政府纷纷响应国家政策号召,上海、成都、北京、贵州等省市通过发放“算力券”等补贴算力建设的方式助力产业发展。

能耗分析

1.能耗指标进一步收紧

到2025年底,算力电力双向协同机制将初步形成,国家算力网络枢纽节点新建数据中心绿电占比超过80%。当前数据中心化石能源使用受限日趋明显,未来数据中心可再生能源利用率将持续提升,其中数据中心绿电使用率的提升,将推动绿色算力进一步发展,有效赋能千行百业节能降碳。智算中心高功耗对散热提出更高要求,液冷散热技术是加快数据中心绿色转型、实现节能降耗的最优解,将逐渐取代传统风冷散热。

数据中心能耗指标PUE与可再生能源利用率已成为重点考核指标。在“双碳”目标下,对数据中心建设要求主要在能耗指标PUE和绿电使用率上,2021年11月国家发展改革委等部门在《贯彻落实碳达峰碳中和目标要求推动数据中心和5G等新型基础设施绿色高质量发展实施方案》中提出,到2025年数据中心运行电能利用效率和可再生能源利用率明显提升,全国新建大型、超大型数据中心平均电能利用效率降到1.3以下,国家枢纽节点进一步降到1.25以下。

2.总能耗不断攀升

智能算力市场需求攀升,算力基础设施的绿色转型可促进下游企业的节能减排及可持续发展。大模型的发展和AIGC应用的落地丰富了人工智能的应用场景,企业加码AI技术研发投入,IDC预计未来三年中国智能算力需求CAGR达48%,其能耗问题也日益凸显。数据中心是全球公认的高耗能行业,生态环境部发布的数据显示,2021年我国数据中心总耗电量达到2166亿千瓦时,占全社会用电量的2.6%,碳排放则占全国碳排放量的1.14%左右。中金公司的券商研报显示,预计到2025年我国数据中心能耗总量将突破4000亿千瓦时。面对如此快速增长的高能耗,液冷技术成为产业节能减排的重要手段之一。

液冷技术展望分析

目前,智算中心的单机柜功率密度不断攀升,要达到上述国家政策的要求,液冷技术的应用成为必然。智算中心采用液冷技术能有效提高散热效率,提升芯片工作稳定性并降低PUE值。

智算中心整体散热概览

智算中心散热全景如图2所示,当前散热技术主要包含风冷与液冷两类。运用风冷技术,热管与VC的散热能力较低,3D VC散热上限扩至1000W,需搭配风扇进行散热,技术简单、成本低,适用于大多数设备。液冷技术具有更高的散热效率,包括冷板式与浸没式两类,其中冷板式为间接冷却,初始投资适中,运维成本较低,技术相对成熟;浸没式为直接冷却,制冷效率非常高,前期投入也较高。智算中心不同制冷方式的比较如表3所示。

图2 智算中心散热全景

表3 智算中心不同制冷方式的比较

液冷产业链分析

电子设备发热的根本原因就是工作能量转化为热能。散热设备是为解决高性能计算设备的热管理问题而设计的,通过直接在芯片或处理器表面消除热量来优化设备性能并延长使用寿命。随着芯片功耗的提升,散热技术从一维热管的线式均温,到二维VC的平面均温,再发展到三维的一体式均温(即3DVC技术路径),最后发展到液冷技术。

液冷的优势主要有以下几点:一是散热效率高,液体的导热能力是空气的15~25倍,相比之下空气往往需要更长的时间来散发热量;二是低噪声,采用液冷方式不会产生空气流动所带来的噪声,使数据中心更加安静;三是灵活性强,液冷的设备体积较小,占用的空间也少,提升数据中心灵活性;四是稳定性强,能够更快速、有效地将芯片产生的大量热量传导到冷却系统,降低芯片温度,减少因温度过高导致的故障,保持芯片工作稳定。

不同制冷技术PUE对比如图3所示,相对于风冷数据中心,液冷数据中心仍处于起步阶段。ICT research调研结果显示,2023年中国通用数据中心市场上液冷数据中心的渗透率接近10%,算力数据中心液冷技术渗透率接近85%,液冷技术在智算中心的应用远高于通用数据中心。随着液冷技术的不断成熟、成本逐渐下降,预计到2025年在通用数据中心市场液冷渗透率将超过30%。

图3 不同制冷技术PUE对比

液冷成本分析

之前市场普遍认为液冷数据中心初期投入和运营成本较高,但伴随液冷技术的发展以及算力需求的激增,形势发生了变化。一方面,冷板液冷数据中心初始建设成本已经低于风冷数据中心;另一方面,浸没式液冷虽前期投入较高,但每年可以大幅降低运营成本(主要为电费),迅速回收投资,数据表明,浸没式液冷数据中心运行4.5年后,TCO将出现拐点并且低于风冷数据中心。

液冷规模分析

目前数据中心的散热方式仍然以风冷为主,在算力设备以及数据中心机房的高热密度趋势和高能效散热要求的双重推动下,预计未来液冷将成为主流的数据中心温控方式。根据ICT research发布的数据,2023年我国液冷温控设备市场规模约为9.27亿元,连续三年持续高速增长。中国液冷温控设备市场规模如图4所示,冷板式和浸没式液冷存量改造市场空间测算如表4所示。

图4 中国液冷温控设备市场规模

表4 冷板式和浸没式液冷存量改造市场空间测算

显然,液冷已经成为未来数据中心绿色化过程中不可或缺的一环。在市场火热的追逐下,技术落地面临的挑战也有望得以加速解决,比如安全性、硬件成本、运维难度等。冷板式液冷是当下数据中心有效降低PUE的手段,并且其兼容性更强、定制化程度更低;浸没式液冷在未来发展空间广阔,市场增长空间也更大。

*本篇刊载于《通信世界》7月10日*

第13期 总947期