ChatGPT 的新 AI 图像生成功能上线仅两天,社交媒体上便已充斥着以日本动画工作室吉卜力风格的 AI 生成梗图,埃隆·马斯克、《指环王》和美国总统唐纳德·特朗普都没“逃过”,甚至 OpenAI 首席执行官萨姆·奥尔特曼也将他的新头像设置为吉卜力风格的图片。(吉卜力工作室以制作《龙猫》和《千与千寻》等热门影片而闻名。)

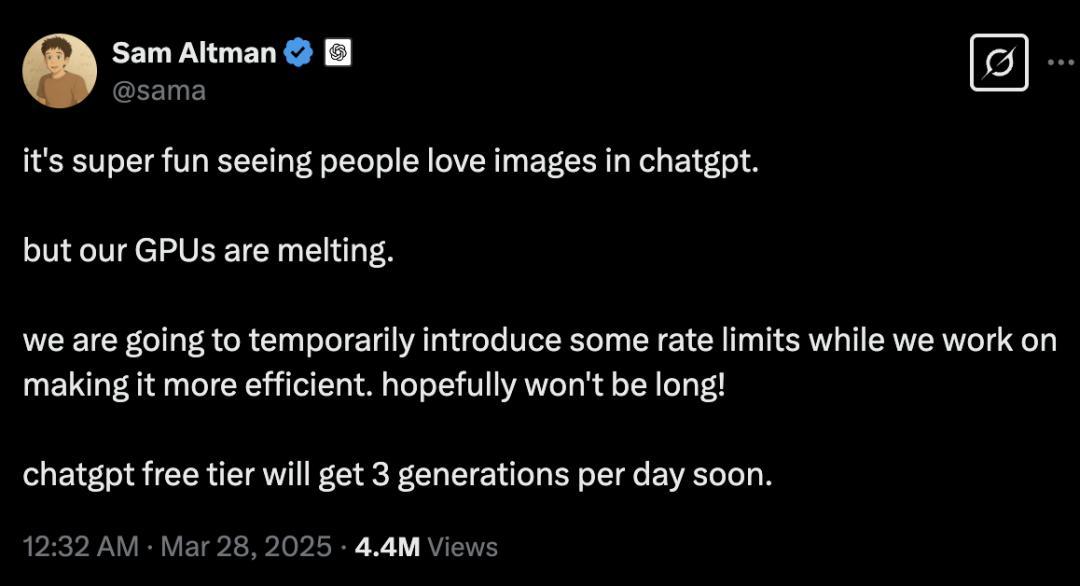

大量用户正在将现有的图像上传到 ChatGPT,并要求聊天机器人以新的风格重新创作这些图像。今天,奥尔特曼在 X 上发文表示:“看到大家如此喜爱 ChatGPT 的图像功能非常有趣,但我们的 GPU 快扛不住了。”虽未具体说明限制次数,但 Altman 称该措施不会持续太长时间,因为他们正在尝试提升处理海量请求的效率,免费用户将“很快”能每天最多生成三张图像。

虽然后续 OpenAI 又宣布了对 GPT-4o 进行了更新,但显然人们的注意力还在“玩图”上。

“我认为,这个功能是过去半年里 OpenAI 发布的 GPT-4o 中最有价值的一个,它确实非常炸裂。相比之下,正式上线的 Sora 以及后来连续 12 天的直播所展示的内容,大多都没有超出人们的预期。”原快手可图大模型负责人李岩说道。

与 SD 等模型比, GPT-4o 赢在了哪里?

“昨天还在看 SD 教程,今天发现白看了……”知名开发者 Jimmy Cheung 发帖说道,“今天情绪非常低落,压力非常大,我不清楚我现在做什么,是从现在开始到将来都还有价值的。”

李岩表示,这次 GPT-4o 火爆的关键在于实现了对话式图像生成。

实际上,基于自然语言指令的图像编辑能力之前已经有了,比如字节 SeedEdit 和 Google Gemini 2.0 都具备相似能力。但在实际生成过程中,指令响应能力没有那么强,效果做得没有那么好。

例如在一致性保持方面,当要求去除背景中的某个物体时,模型可能还去掉了其他的东西;或者在对人物进行特定修改时,最终效果可能是不像原来的人了。此外,还存在指令不响应的问题,比如要求添加某些元素时未能执行。

但这次 GPT-4o 的交互方式所达到的文本跟图像的响应是非常精准的,大大超出了大家的预期。

李岩分析,虽然 OpenAI 没有发布详细的技术报告,但有一点非常明确:他们一定采用了自回归框架(Autoregressive Model, AR),只有自回归框架才能实现如此自然的图文交互效果。后续大概率也接入了 decode 模块后再做图像生成,但其整体框架已经完全统一到了自回归框架之下。

具体说来,Flux、Stable Diffusion 等模型,现在的做法都是将文本表征和图像生成过程进行解耦,然后扩散模型出图。这种方式通常要先对文本进行完整表征,例如通过 CLIP 或大语言模型提取特征,然后将该特征直接输入扩散模型,并要求扩散模型在生成图像的整个过程中持续参考这个固定的文本特征。这个文本特征的来源是用户输入的 prompt,某种编码器的方式会对 prompt 进行特征提取。

然而问题在于:特征提取完成后,信息量就被固定了。在文本到图像的生成过程中,100% 的原始信息都存在于用户输入的文本 prompt 中,但经过文本编码或表征提取后可能只剩下 70% 的信息,这意味着后续最多就只能基于这 70% 的信息量进行图像生成。

当前几乎所有图像生成模型都采用了上述模式。但可以看出,这些模型在生成文本表征时都会不可避免地造成信息损失,而这种损失一旦形成固定的 embedding 或表征就无法挽回,这一阶段出现的信息缺失,后续扩散模型在生成图像时是无法回溯弥补的。

当前,扩散模型的扩充方式是 prompt engineering(提示词工程)。但是,提示词工程只能扩展成显式描述,比如输入“一个漂亮的小女孩”,系统会将其扩展为非常详细的描述,包括小女孩戴着什么样的帽子、出现在什么样的背景下等等。但这种方式在后续建模中仍然需要提取文本特征,依然会造成信息损失。只要是采用二阶段的方式,即先建模文本再以文本为条件输入扩散模型,就必然会因为文本建模过程中的信息损失导致最终生成的图像无法与文本描述 100% 对齐。

GPT-4o 之所以强大,关键在于它能有效处理用户提供的简洁信息。例如,用户通常只会简单地输入:“帮我画一只小猫或小狗”,但不会给出具体是什么样的猫或狗。现在,GPT-4o 统一到大语言模型的自回归框架下,所以天然具备了语义泛化能力。这种能力本质上源于模型本身的知识储备,使其能够准确理解用户简单文字背后代表的真正的、稠密的信息量是什么。

正是由于 GPT-4o 拥有强大的大语言模型作为知识基础,它才能在完整的端到端框架中实现如此精准的理解和生成能力,这一点至关重要。模型输入的就是用户的原始 prompt,然后直接出图,中间过程中没有二阶段损失,都是一阶段做的,可以充分利用大语言模型所带来的隐式知识,包括扩充 prompt 等。

另外一点是,原来的方法仅支持单轮操作,即输入文字生成提示词,再通过特征提取生成图像,但无法支持多轮条件控制。

GPT-4o 可以直接将图片按照上传图片的风格生成新图像,其中关键在于需要理解上下文中的具体指向,如“刚才提到的狗的照片是哪一张”,这需要大语言模型具备跨模态理解能力。在自回归框架下,上下文从纯文本扩展到了文本 + 图像,因此模型能轻松 get 上下文,甚至远程的上下文。

值得注意的是,从出图质量来看,目前基于自回归框架的生成效果并没有碾压式地超过扩散模型,甚至可能还不如扩散模型的表现。现阶段,两者的生成质量水平其实相差不大。

李岩指出,这仅仅是就出图效果而言,我们更应该关注的是交互方式的差异。未来在交互体验方面,自回归框架显然具有更大的理论优势,它能够更好地兼容完全开放的自由度,实现更接近自然语言对话式的交互方式。

“这种 Interleaved 的图文交错技术才是真正原生的多模态大模型。”李岩认为,在当前行业中,真正意义上的原生全模态的大模型领域里,OpenAI 还是走在最靠前的。

此外,李岩表示,“文生图架构没有什么可以争议的了,在 2025 年这个话题就不是话题了。”

自回归框架对于多模态里面的文本模态、音频模态,自不用多说,基本上已经证明了是可行的,难点在于视觉模态。现在行业内最好的模型,包括开源的 Flux、闭源的可灵、Sora 等,还在用 DIT 的架构,真正做到高精度的视觉生成现在还离不开扩散模型,但图像生成领域,单靠自回归框架实际上是有可能达到一个新的高度的,这件事情 GPT-4o 已经给出了答案。

李岩还大胆设想,如果 GPT-4o 接入联网功能并整合 RAG 技术,其在图像生成方面的潜力将更加巨大。通过 RAG 技术,模型可以直接检索到用户所指的网络流行梗或热点,用户就不需要再上传参考图片了。例如,当用户想生成网络流行表情包时,GPT-4o 可能无需参考图片,仅凭对网络流行文化的理解就能准确捕捉到用户想要的梗,这将进一步提升文生图应用的便捷性和准确性。

是否会吞噬所有产品?

OpenAI 发布 GPT-4o 文生图功能后,Jimmy Cheung 的评价是:GPT-4o 的图像能力,直接干翻了之前很多创业公司的产品,他们花了那么多时间、人力、投资人的钱去调优的算法、工作流、模型,直接被一次大模型的更新就取代了。

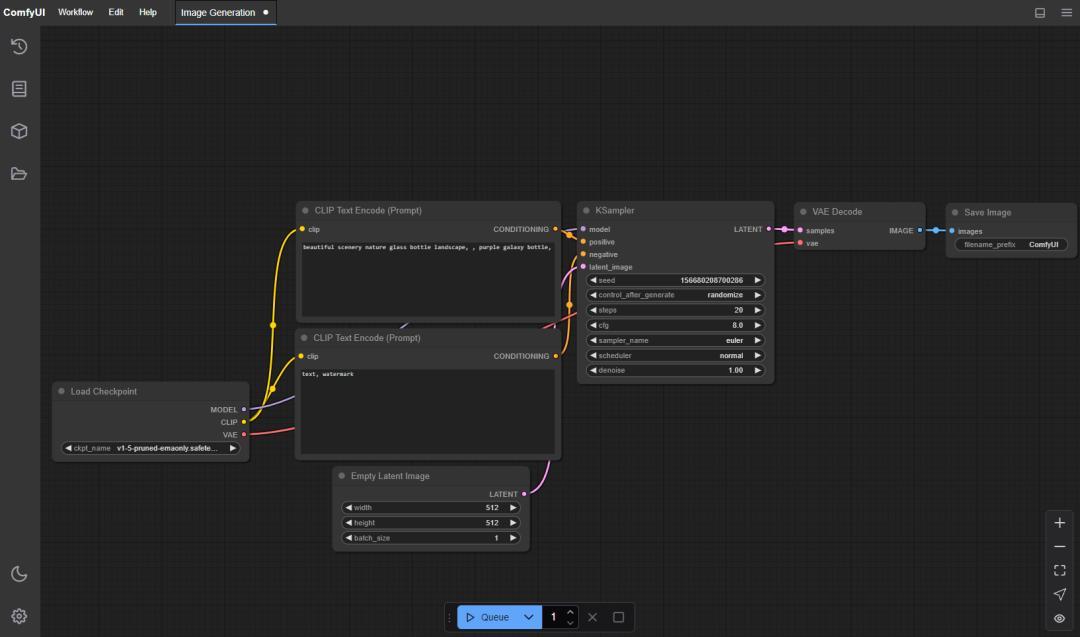

除了 Jimmy Cheung 吐槽“SD 白学了”,还有网友感叹,学了两年的作图工具流 comfyUI 也白学了。一部分人直接大呼:工作流已死。事实上,对于像 comfyUI 这样的工作流产品而言,情况可能没有那么悲观。

“GPT-4o 目前为止的结果确实挺颠覆,但在真正的商业化可用的能力上,现在不太行,相当长一段时间还是要依赖 comfyUI。”李岩说道。

比如,当前 GPT-4o 的出图大小并不能满足实际商拍场景里的需求,分辨率的提高会需要一些外接能力。另外,OpenAI 在照片改换风格时是做全图的重绘,细化到了图像的每一个像素点,但在实际情况中,用户可能只需要改某一块地方,其他地方,甚至一个像素值都不能动,这样的需求就需要 comfyUI 这类非常细粒度的工作流方式去精细化处理。

comfyUI 里面有后处理、抠图、调整亮度等很多链路,支持使用基于图形、节点和流程图的界面来设计和执行高级的稳定扩散流水线。

“对于轻娱乐场景或者要求没有那么高的批量生产场景,GPT-4o 现在已经可以发挥价值了。但对于容忍度比较低、项目要求非常高的场景,未来相当长一段时间里还是要依赖 comfyUI。”李岩总结道。

但是,GPT-4o 对于 Prompt 工程可能会是致命打击。

“Prompt 工程这件事有可能以后变得也没那么重要了。”李岩解释称,现在 Prompt 对文生图、文生视频模型很重要,是因为整个文本侧和图像侧还没有办法做到那么强的 alignment 效果,所以需要尽可能把文本侧的内容写明确、减少信息损失,因此诞生了 prompt engineer。但实际上未来这部分工作如果如果能统一到 GPT-4o 的框架里,这份工作大家慢慢就不需要了。就算 Prompt 写的不好也没关系,还可以再改,只需把不满意的改进点用自然语言描述给模型,模型就会理解到底应该怎么改。

在李岩看来,GPT-4o 这次更加证明了工具型产品会更容易被大模型能力吞噬。比如美颜类工具,对于不懂美颜的男生来说,语言交互就可以得到理想的效果。

但显然,作为正在遭受“冲击”的 Midjourney 并不这样想。Midjourney CEO David Holz 犀利指出:GPT-4o 的图像生成速度慢、效果又差,OpenAI 只是为了筹集资金,而且在以一种不良竞争的方式行事。这不过是一时的噱头,并非创作工具,不出一周就没人会再谈论它了。

据称,Midjourney 准备在下周推出最新的 V7 版。值得注意的是,领导 Midjourney V2 至 V7 模型开发的核心人物 theseriousadult 在 3 月 21 日宣布离职,之后将加入 Cursor 转做 AI 编程 Agent。

而早在 GPT-4o 掀起此次关于“大模型是否会吞噬所有产品”的热议之前,AI 科技公司 Pleias 联合创始人 Alexander Doria 就提出了“模型就是产品”的观点。他明确指出:所有投资者一直都在押注应用层,但在人工智能进化的下一阶段,应用层很可能是最先被自动化和颠覆的。同时,Doria 还认为,OpenAI 的 DeepResearch 和 Claude Sonnet 3.7,以及“不仅把模型当作产品,而且将其视为通用基础设施层”的 DeepSeek,都是“模型作为产品”的典型示例。

不过,就目前的大模型能力来看,大模型暂不能覆盖到所有的应用产品。但这种低门槛的使用形式,似乎正一步步瓦解许多现有的各类产品逻辑和形态。

结束语

大模型更多是在做技术平权这件事,就是让很多不懂技术的人逐渐都可以公平地使用大模型。在技术迅速变化的当下,每个人,甚至企业都很容易被迫进行战略调整,甚至转向。

李岩的建议是,首先,要明确自己在这个行业中的具体业务需求。其次,在实际工作中,每个人都应该采取两种策略:一是“低头走路”,确保自己对所用工具的理解和运用熟练,从而稳步前进;二是“抬头看路”,关注行业的发展和变化。这两者不是相互排斥,而是需要同时进行,以便我们在专注工作的同时,及时调整方向。

李岩认为,未来大模型的发展将深刻影响各行业的组织形态和人员能力结构。以传统的人才金字塔为例,其结构通常分为底层、中腰部和顶层。目前看来,底层能力画像的人会被大面积“吞噬”,接着是腰部能力的人群,而最头部的那部分人永远不会被大模型吞噬,因为大模型本身也需要他们的 feedback 和教化。

“所以,每一个人应该尽量避免做技术含量低的工作,而是慢慢往上去走。”李岩说道。