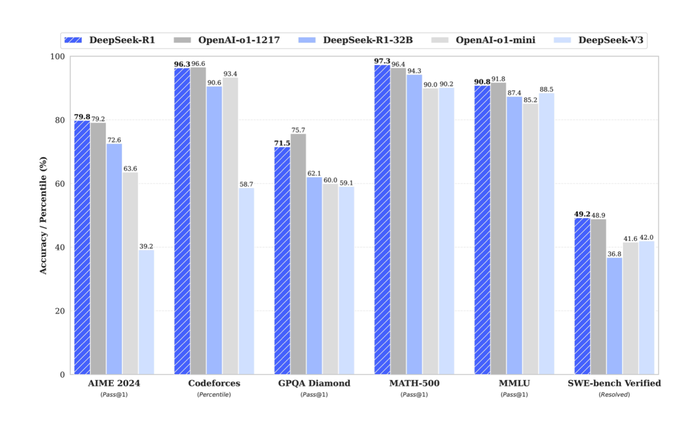

从去年年底开始,国产 AI 大模型迅速崭露头角,其中由幻方量化旗下深度求索公司研发的 Deepseek,凭借其卓越表现,在上个月震撼了整个人工智能行业。这家位于杭州的中国公司将中国 AI 技术推向了世界一流的水准,并于 2025 年 1 月 20 日开源了 Deepseek R1 大模型。关于 Deepseek,这段时间也传来不少新闻,包括它曾遭遇黑客攻击,因此限制国外手机号注册 Deepseek 账号等问题。与此同时,OpenAI 首席执行官 Sam Altman 在社交平台 X 上发布了关于 ChatGPT 的未来规划,透露将为所有用户提供免费版 ChatGPT 的无限聊天权限,但需遵守滥用阈值,并计划推出 ChatGPT-4.5 和 ChatGPT-5。这些消息从侧面印证了 Deepseek R1 已经达到与 ChatGPT-4 相媲美的国际水平。

本文将介绍如何在安卓手机和桌面设备上分别部署本地运行的 Deepseek R1 模型,并搭建知识库。那么,为什么选择在本地部署 AI 大模型呢?本地部署 Deepseek 具有诸多显著优势。首先,数据隐私得到更好的保障,用户的私人数据无需上传至云端或第三方服务器,从而大大降低了数据泄露的风险。第二点,本地部署能够显著提高响应速度,因为无需依赖网络连接和远程服务器,特别是在网络不稳定时,用户体验更加流畅,尤其是现在 Deepseek 的官网由于大量用户访问已经造成了大概率都是“服务器繁忙,请稍后再试。”此外,离线使用是另一个重要优势,用户可以在没有网络环境的情况下,依然享受模型的服务,适用于高安全性或特殊场景。最后一点,通过本地部署,用户可以建立自己的数据库,实现对数据的完全控制和管理,进一步提高数据处理的灵活性与安全性。

当然,与此同时,运行 DeepseekAI 大模型需要强大的计算资源,如高性能的 CPU、GPU,以及大容量的内存和存储设备。这对于普通笔记本电脑而言,可能需要升级硬件,增加了成本和复杂性。部署完成的 R1 模型在推理能力、网络资源整合等方面肯定是不如直接从网页访问回答的准确和智能。

安卓端

部署 Ubuntu 环境

首先,需要准备相关工具。进入 Github 官网,搜索 Termux,找到最新的 APK 应用包并进行安装。Termux 是一款终端模拟器应用程序,专为 Android 系统设计,提供完整的 Linux 环境,允许用户在 Android 设备上运行 Linux 命令和工具,无需 root 权限。后续将通过 Termux 环境部署 Deepseek R1 模型。建议使用骁龙 8 Gen2 以上的设备进行部署,以保证性能。

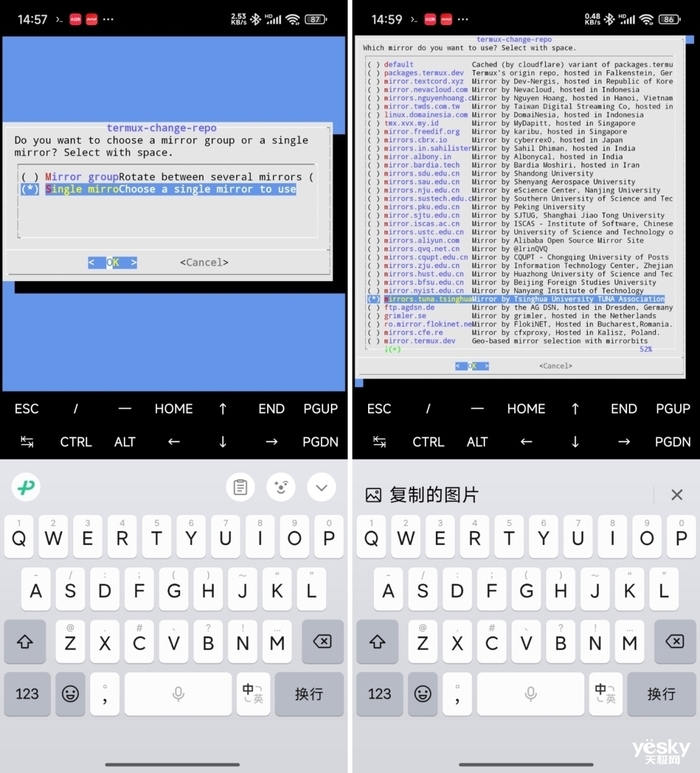

进入 Termux 软件,输入termux-change-repo指令并运行:

应用程序内会弹出一个窗口,选择运行单个镜像文 “Single mirror Choose a single mirror to use”,并点击:

在下一个界面,找到清华大学镜像文件源(Tsinghua University),如果没有找到,可以通过双手捏和将显示界面缩小找到,随后同样点击:

此时重新回到命令行界面,输入“pkg update && pkg upgrade”,更新升级至最新的软件包,等待完成后,输入“y”,

下一步,部署 Ubuntu 环境,需要一定的网络条件,分别安装顺序执行一下操作部署安装 Ubuntu工具,pkg i proot-distro,此命令使用 pkg 包管理器安装 proot-distro 工具,proot-distro install ubuntu:使用 proot-distro 工具安装 Ubuntu 发行版,安装完成后,再输入proot-distro login ubuntu:登录到已安装的 Ubuntu 环境,进入 Ubuntu 的命令行界面。完成以上操作后在命令行界面会有“ root@localhost:~#”,即表示成功进入Ubuntu 环境,此次下载部署在本地的Deepseek R1模型即将运行在此环境中。

下载 Deepseek 模型

在上一步最后的Ubuntu 环境命令行界面,输入“curl -fsSL https://ollama.com/install.sh | sh”,通过ollama官网下载Deepseek模型,等待进度条完成,需要一定的网络条件,随后进入如下界面:

在分别执行“OLLAMA_HOST=0.0.0.0”、“ OLLAMA_ORIGINS=* ”、“ollama serve”三个指令,更改接口并且运行ollama服务。此时,回到桌面,长按Termux图标,点击“New session”,回到应用内输入两个指令,启动Ubuntu环境,并下载ollama模型,回到Termux应用,输入“proot-distro login ubuntu”和“ollama run deepseek-r1:1.5b”,再输入回车,模型开始下载,等待完成即可。

不建议下载过于复杂的模型,数字越大意味着部署的模型就越聪明,同时所需的手机性能也会越高。

通过Chatbox 与 Deepseek 交互

模型下载完成后,不要关闭Termux 进程的后台,进入 Chatbox 官网,下载安卓版本 APK 文件完成应用安装,打开应用后,点击“使用自己的 API Key 或本地模型”,模型提供方依次选择 Ollama API,模型选择“Deepseek-r1:1.5 b”,可以对模型进行身份设定,方便回答用户问题,随后关闭Termux 和 Chatbox 应用。

每次启动 Chatbox 之前,重新打开 Termux 进入 Ubuntu 环境并 运行 ollama 模型,输入以下两个指令:“proot-distro login ubuntu”和“ollama serve”,回到 Chatbox,即可与 Deepseek 交流了。

受限于手机性能,可能需要一定的响应时间,请耐心等待,以下是实际体验,为了避免手机清理后台,建议将 Termux 锁定在后台。ok,以上为手机端部署 Deepseek 的全部内容了。

桌面端 Deepseek 建立知识库

在手机端部署本地 Deepseek 大模型相对复杂,但只要按照步骤操作,实际上可以很快完成部署。与此相比,桌面端的 Deepseek 部署要简单得多。桌面端不需要建立额外的环境,Windows 和 Mac 端的步骤大致相同,因此本文将重点介绍如何通过本地 Deepseek R1 模型在 Mac 端搭建自己的知识库。

下载 Ollama 模型

首先,访问 Ollama 官网,选择并下载适合 Mac 系统的版本。下载完成后,按照提示完成安装,安装后将解压得到的 Ollama 程序拖动到“应用程序”中。

接着,打开 Mac 系统的“终端”应用(Windows 用户则打开 CMD),在终端中输入需要下载的 Ollama 模型对应的代码。具体的代码可以参考 Ollama 官网提供的说明。如果电脑配置较强,可以选择下载较大的模型版本。

需要注意的是,如果在下载过程中发现下载速度变慢,可以关闭当前的“终端”窗口,再重新打开并输入相同的指令。这样可以恢复更高的下载速度,并且下载进度会被保留,不会丢失。

搭建本地知识库

完成 Ollama 模型的下载后,接下来是搭建知识库。首先,访问 “AnythingLLM” 官网,根据操作系统下载并安装对应的版本。

安装完成后,打开程序,选择 “Ollama” 作为模型提供方,并选择 “8b (依据电脑配置)模型”。进入下一步时,跳过邮箱填写界面,直接创建一个新的工作区(Workspace)。

创建工作区后,进入到对话界面。接下来,点击工作区 “Test001”的设置按钮,进入“聊天设置”页面。在聊天提示框中对 AI 助手进行一些基本设定,以便模型能够更快速、更精准地回答用户的问题。同时,可以设置回答语言为中文,并保存这些设置。

接下来,需要上传并嵌入知识库文件。小编通过 AI 创建了一家虚拟的游戏公司,并将公司简介整理成一个 Word 文档。在准备好文件后,返回“Test001”工作区,点击右侧的上传按钮,将文件上传至“My Documents”。选中该文件后,点击 “Move to Workspace”,然后选择 “Saved and Embed” 以保存文件,最后执行“Pin to Workspace”操作。这些操作都会有提示,确保每个步骤都正确完成。

测试和提问

知识库搭建完成后,回到对话框,在工作区“Test001”中选择 “New Thread” 创建一个新的对话框。此时,可以开始向模型提问与知识库相关的问题。大模型将根据文档内容做出准确回答,确保知识库的内容能够被有效利用。

(知识库内容)

(AI 依据数据库的核心人员回答)

(AI 依据数据库的回答)

总结

以上是手机端部署本地 Deepseek 的教程以及通过 Mac 端部署 Deepseek R1 大模型并建立本地知识库的完整教程。从下载模型、搭建知识库到最后的测试与提问,每一步都很关键,只要按照步骤操作,就能够顺利完成整个过程。希望这篇教程能够帮助大家顺利搭建属于自己的本地知识库,提升使用 AI 模型的效率和体验。