编辑:泽南

现在,你可以指导 GPT-4o 的说话方式了。

今天凌晨,OpenAI 突然开启了新产品发布直播,这次新发布的内容全是音频模型。

编辑:泽南

现在,你可以指导 GPT-4o 的说话方式了。

今天凌晨,OpenAI 突然开启了新产品发布直播,这次新发布的内容全是音频模型。

据介绍,它们实现了新的 SOTA 水平,在准确性和可靠性方面优于现有解决方案——尤其是在涉及口音、嘈杂环境和不同语速的复杂场景中。这些改进提高了语音 / 文本转录应用的可靠性,新模型特别适合客户呼叫中心、会议记录转录等用例。

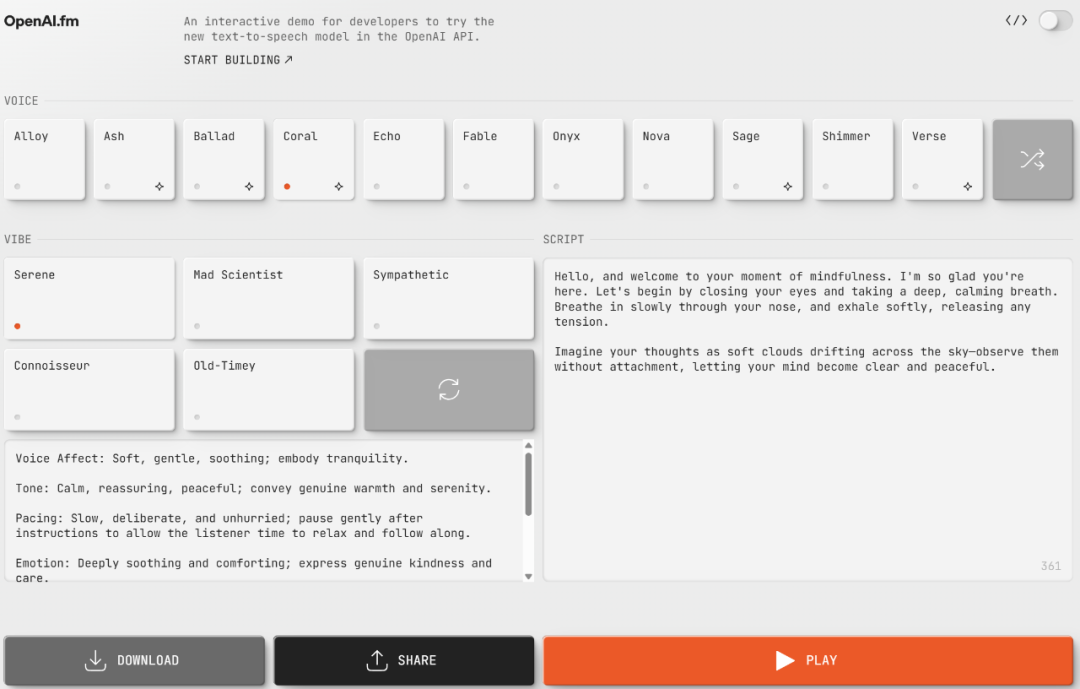

基于新的 API,开发人员第一次可以指示文本转语音模型以特定方式说话,例如让 AI「像富有同情心的客户服务人员一样说话」,从而为语音智能体开启新的定制化维度,可以实现各种定制应用程序。

OpenAI 于 2022 年推出了第一个音频模型,并一直致力于提高这些模型的智能性、准确性和可靠性。借助新的音频模型及 API,开发人员可以构建更准确、更强大的语音转文本系统以及富有表现力、个性十足的文本转语音声音。

具体来说,新的 gpt-4o-transcribe 和 gpt-4o-mini-transcribe 模型与原始 Whisper 模型相比改进了单词错误率,提高了语言识别和准确性。

gpt-4o-transcribe 在多个既定基准中展示了比现有 Whisper 模型更好的单词错误率 (WER) 性能,实现了语音转文本技术的重大进步。这些进步源于强化学习创新以及使用多样化、高质量音频数据集进行的大量中期训练。

这些新的语音-文本模型可以更好地捕捉语音的细微差别,减少误认,并提高转录可靠性,尤其是在涉及口音、嘈杂环境和不同语速的具有挑战性的场景中。

几种模型的单词错误率(越低越好)。

在 FLEURS 上,OpenAI 的模型实现了更低的 WER 和强大的多语言性能。WER 越低越好,错误越少。

OpenAI 还推出了一个可操纵性更好的新 gpt-4o-mini-tts 模型。在其之上,开发人员第一次可以「指导」模型,不仅可以指导模型说什么,还可以指导模型如何说,从而为大量用例提供更加定制化的体验。该模型可在 text-to-speech API 中使用。不过目前,这些文本转语音模型仅限于人工预设的声音,且受到 OpenAI 的监控。

就在昨天,OpenAI 推出的「最贵大模型 API」o1-pro API 还因为每百万 token 收费 600 美元而遭到了 AI 社区的广泛吐槽。今天 OpenAI 推出的三款语音 API 价格倒是保持了业界平均水准:gpt-4o-mini-tts 的百万 token 文本输入价格是 $0.60,音频输出价格为 $12.00;gpt-4o-transcrib 文本输入价格是 $2.50,音频输入价格 $10.00,音频输出价格 $6.00;gpt-4o-mini-transcribe 的文本输入价格是 $1.25,音频输入价格 $5.00,音频输出价格 $3.00。

因此今天的发布也受到了人们的欢迎。

OpenAI 的新音频模型基于 GPT‑4o 和 GPT‑4o-mini 架构,并在专门的以音频为中心的数据集上进行了广泛的预训练,这对于优化模型性能至关重要。这种有针对性的方法可以更深入地了解语音细微差别,并在与音频相关的任务中实现出色的性能。

在模型训练中,OpenAI 增强了提炼技术,使知识从最大的音频模型转移到了更小、更高效的模型上。利用先进的自我博弈方法,OpenAI 的提炼数据集有效地捕捉了真实的对话动态,复制了真正的用户助手交互,这有助于小型模型提供出色的对话质量和响应能力。

OpenAI 的语音转文本模型集成了大量强化学习,将转录准确性推向了最先进的水平。据称,这种方法大大提高了精度并减少了幻觉,使语音转文本解决方案在复杂的语音识别场景中具有极强的竞争力。

这些发展代表了音频建模领域的进步,将创新方法与实用增强功能相结合,以增强语音应用程序的性能。

对于已经使用基于文本的模型构建对话体验的开发人员,添加 OpenAI 语音转文本和文本转语音模型是构建语音智能体的最简单方法。OpenAI 发布了与 Agents SDK 的集成以简化此开发过程。对于希望构建低延迟语音转语音体验的开发人员,OpenAI 建议使用 Realtime API 中的语音转语音模型进行构建。

在未来,OpenAI 计划继续提升音频模型的智能性和准确性,并探索允许开发人员使用自定义声音构建更加个性化体验的方法。包括视频等更多模态的能力也在研发过程当中。

© THE END